Delphi Digital : Analyse approfondie des opportunités et des défis de la DeAI

Auteur original : PonderingDurian, chercheur numérique Delphi

Traduction originale : Pzai, Foresight News

Étant donné que les crypto-monnaies sont essentiellement des logiciels open source dotés d’incitations économiques intégrées et que l’IA perturbe la manière dont les logiciels sont écrits, l’IA aura un impact énorme sur l’ensemble de l’espace blockchain.

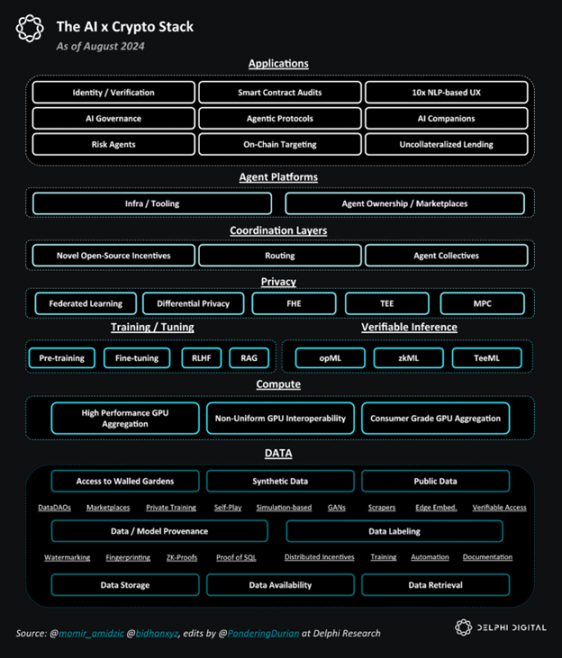

Pile globale AI x Crypto

DeAI : opportunités et défis

À mon avis, le plus grand défi auquel est confrontée la DeAI réside dans la couche d’infrastructure, car la création de modèles de base nécessite beaucoup de capital, et les retours d’échelle pour les données et le calcul sont également élevés.

Compte tenu de la loi d’échelle, les géants de la technologie ont un avantage naturel : après avoir réalisé d’énormes profits grâce au monopole de l’agrégation de la demande des consommateurs pendant la phase Web2 et avoir réinvesti ces profits dans l’infrastructure cloud pendant une décennie de tarifs artificiellement bas, les géants de l’Internet tentent désormais de conquérir le marché de l’IA en dominant les données et l’informatique (éléments clés de l’IA) :

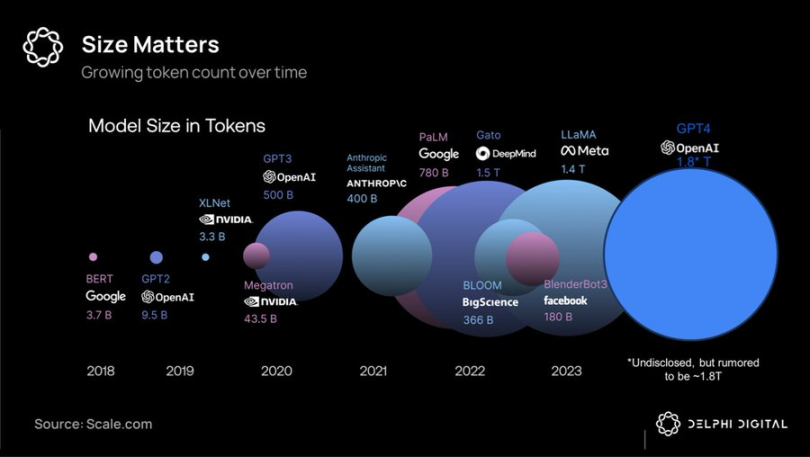

Jeton comparaison de volume d'un grand modèle

En raison de l’intensité capitalistique et des besoins élevés en bande passante de la formation à grande échelle, les superclusters unifiés restent la meilleure option – fournissant aux géants de la technologie les modèles à source fermée les plus performants – qu’ils prévoient de louer à des profits de type monopolistique et de réinvestir les bénéfices dans chaque génération ultérieure de produits.

Cependant, il s’avère que le fossé dans le domaine de l’IA est plus profond que l’effet de réseau Web2, et les principaux modèles de pointe se déprécient rapidement par rapport au domaine, d’autant plus que Meta a adopté une politique de la terre brûlée et a investi des dizaines de milliards de dollars pour développer des modèles de pointe open source tels que Llama 3.1, dont les performances ont atteint les niveaux SOTA.

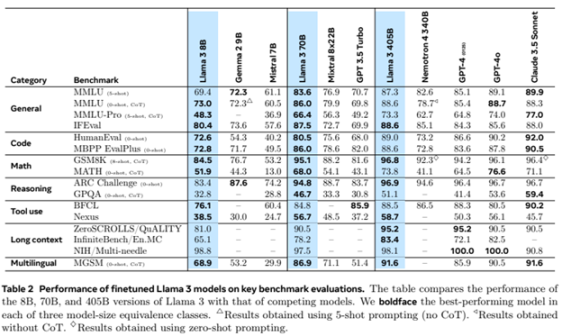

Évaluation du modèle Llama 3 Grand

À ce stade, combiné aux recherches émergentes sur les méthodes de formation décentralisées à faible latence, cela pourrait banaliser (des parties de) modèles commerciaux de pointe - à mesure que les prix des smartphones baissent, la concurrence se déplacerait (au moins partiellement) des superclusters matériels (qui favorisent les géants de la technologie) vers l'innovation logicielle (qui favorise légèrement l'open source/la crypto-monnaie).

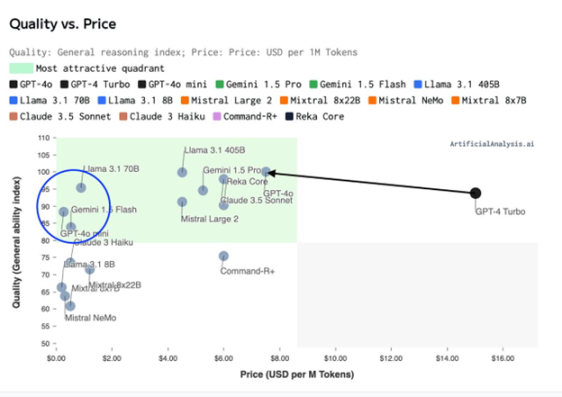

Indice de capacité (qualité) – Tableau de distribution des prix de formation

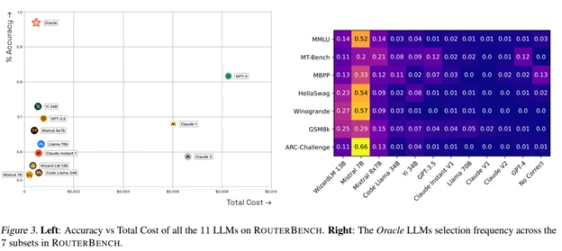

Étant donné l’efficacité informatique des architectures « mixtes d’experts » et de la synthèse/routage de modèles de grande taille, nous ne sommes probablement pas confrontés à un monde de 3 à 5 modèles géants, mais à un monde de millions de modèles avec différents compromis coût/performance. Un réseau (une ruche) d’intelligence entrelacée.

Cela pose un énorme problème de coordination : un problème que les mécanismes d’incitation basés sur la blockchain et les cryptomonnaies devraient pouvoir très bien contribuer à résoudre.

Principaux domaines d'investissement DeAI

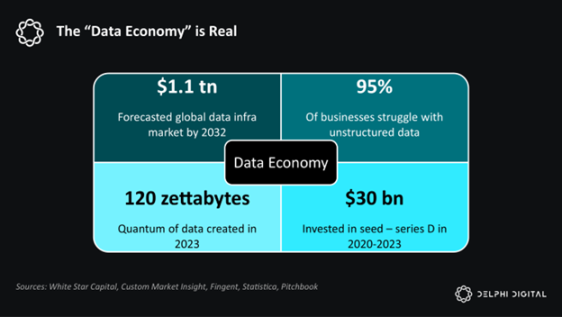

Les logiciels dévorent le monde. L'IA dévore les logiciels. Et l'IA est essentiellement constituée de données et de calculs.

Delphi est optimiste quant aux composants de cette pile :

Simplification de la pile IA x Crypto

Infrastructure

Étant donné que l’IA est alimentée par les données et le calcul, l’infrastructure DeAI se concentre sur l’obtention de données et de calculs aussi efficacement que possible, souvent en utilisant des incitations en cryptomonnaie. Comme nous l’avons mentionné précédemment, il s’agit de la partie la plus difficile de la compétition, mais compte tenu de la taille du marché final, elle peut également être la plus gratifiante.

calculer

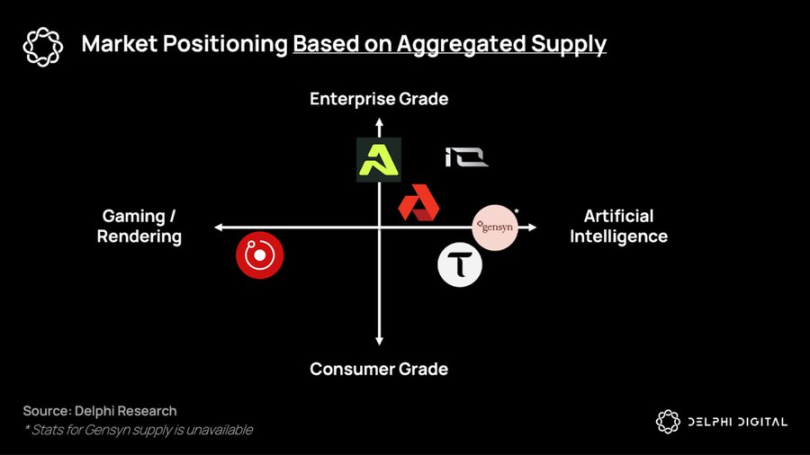

Les protocoles de formation distribuée et le marché des GPU ont été jusqu'à présent limités par des retards, mais ils espèrent coordonner le potentiel du matériel hétérogène pour fournir des services informatiques à moindre coût et à la demande à ceux qui sont exclus des solutions intégrées des géants. Des entreprises telles que Gensyn, Prime Intellect et Neuromesh sont à l'origine du développement de la formation distribuée, tandis que des entreprises telles que io.net, Akash, Aethir et d'autres permettent une inférence à faible coût plus proche de l'intelligence de pointe.

Répartition des niches de projets en fonction de l'offre globale

données

Dans un monde d’intelligence omniprésente basée sur des modèles plus petits et plus spécialisés, les actifs de données sont de plus en plus précieux et monétisables.

Jusqu'à présent, DePIN a été largement salué pour sa capacité à construire des réseaux matériels à un coût inférieur à celui des entreprises à forte intensité de capital telles que les sociétés de télécommunications. Cependant, le plus grand marché potentiel de DePIN résidera dans la collecte de nouveaux types d'ensembles de données qui seront intégrés dans des systèmes intelligents en chaîne : les protocoles proxy (discutés plus loin).

Dans un monde où le plus grand marché potentiel du monde – le travail – est remplacé par les données et le calcul, l’infrastructure de l’IA offre un moyen aux personnes non techniques de s’emparer des moyens de production et de contribuer à l’économie de réseau à venir.

intergiciel

L'objectif ultime de DeAI est de permettre un calcul composable efficace. Comme le Lego capital de DeFi, DeAI compense le manque de performance absolue actuel grâce à une composabilité sans autorisation, incitant un écosystème ouvert de logiciels et de primitives informatiques à continuer de se composer au fil du temps, surpassant ainsi (espérons-le) les logiciels et les primitives informatiques existants.

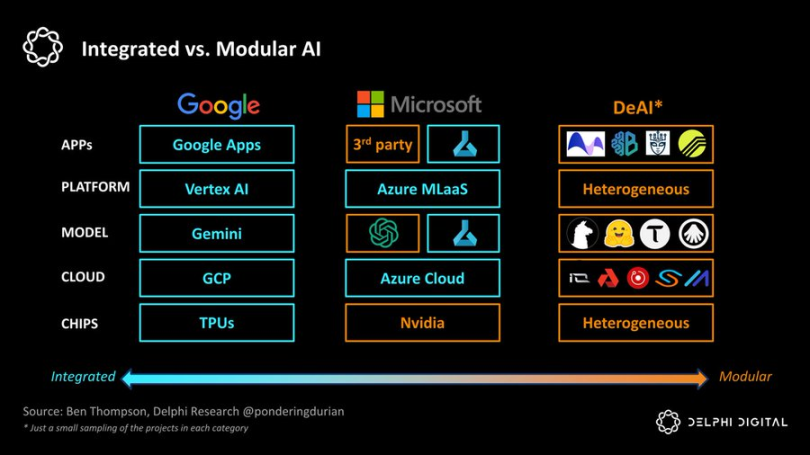

Si Google est l’extrême de « l’intégration », DeAI représente l’extrême de la « modularisation ». Comme nous le rappelle Clayton Christensen, dans les industries émergentes, les approches intégrées tendent à réduire les frictions dans la chaîne de valeur, mais à mesure que le domaine mûrit, les chaînes de valeur modulaires gagnent du terrain en augmentant la concurrence et l’efficacité des coûts à chaque niveau de la pile :

IA intégrée ou IA modulaire

Nous sommes très optimistes sur plusieurs catégories qui sont essentielles pour atteindre cette vision modulaire :

routage

Dans un monde d'intelligence fragmentée, comment choisir le bon mode et le bon moment au meilleur prix ? Les agrégateurs côté demande ont toujours capté de la valeur (voir la théorie de l'agrégation), et les fonctions de routage sont essentielles pour optimiser la courbe de Pareto entre performances et coûts dans un monde d'intelligence en réseau :

Bittensor a été à l’avant-garde de la première génération de produits, mais un certain nombre de concurrents dédiés ont émergé.

Allora organise des compétitions entre différents modèles sur différents « sujets » de manière « contextuelle » et auto-améliorante au fil du temps, éclairant les prédictions futures en fonction de leur exactitude historique dans des conditions spécifiques.

Morpheus vise à être le « routage côté demande » pour les cas d'utilisation du Web3 - essentiellement une « Apple Intelligence » avec un proxy local open source qui comprend le contexte pertinent de l'utilisateur et peut acheminer efficacement les requêtes via les blocs de construction émergents de DeFi ou l'infrastructure de « calcul composable » du Web3.

Les protocoles d'interopérabilité des agents tels que Theoriq et Autonolas visent à pousser le routage modulaire à l'extrême, permettant à un écosystème composable et composite d'agents ou de composants flexibles de devenir un service en chaîne pleinement mature.

En résumé, dans un monde où l'intelligence se fragmente rapidement, les agrégateurs côté offre et côté demande seront extrêmement puissants. Si Google est une entreprise de 1 million de livres sterling à 10 millions de livres sterling qui indexe les informations du monde entier, alors le gagnant du routeur côté demande — qu'il s'agisse d'Apple, de Google ou d'une solution Web3 — l'entreprise qui indexe les renseignements par proxy aura une échelle beaucoup plus grande.

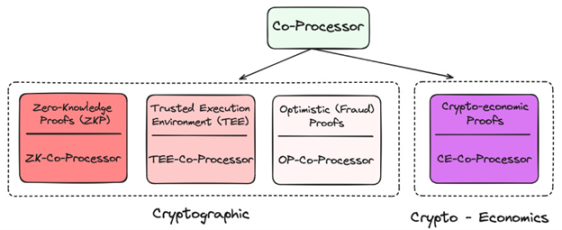

Coprocesseur

Étant donné sa nature décentralisée, la blockchain est très limitée en termes de données et de calcul. Comment intégrer les applications d'IA gourmandes en calcul et en données dont les utilisateurs ont besoin à la blockchain ? Grâce aux coprocesseurs !

Couche d'application du coprocesseur dans Crypto

Ils proposent tous des techniques différentes pour vérifier que les données ou le modèle sous-jacent utilisé sont un oracle valide, ce qui minimise les nouvelles hypothèses de confiance sur la chaîne tout en améliorant considérablement ses capacités. À ce jour, de nombreux projets ont utilisé zkML, opML, TeeML et des méthodes crypto-économiques, et leurs avantages et inconvénients varient :

Comparaison de coprocesseurs

À un niveau supérieur, les coprocesseurs sont essentiels à l'intelligence des contrats intelligents : ils fournissent une solution de type « entrepôt de données » pour interroger une expérience en chaîne plus personnalisée ou pour vérifier qu'une inférence donnée a été effectuée correctement.

Les réseaux TEE (Trusted Execution) tels que Super, Phala et Marlin sont devenus de plus en plus populaires récemment en raison de leur praticité et de leur capacité à héberger des applications à grande échelle.

Dans l’ensemble, les coprocesseurs sont essentiels pour fusionner des blockchains hautement déterministes mais peu performantes avec des agents hautement performants mais probabilistes. Sans coprocesseurs, l’IA ne serait pas présente dans cette génération de blockchains.

Incitations pour les développeurs

L’un des plus gros problèmes du développement de l’open source dans le domaine de l’IA est le manque d’incitations pour le rendre durable. Le développement de l’IA nécessite beaucoup de capitaux et les coûts d’opportunité des travaux de calcul et de connaissance de l’IA sont très élevés. Sans les bonnes incitations pour récompenser les contributions de l’open source, le domaine perdra inévitablement face aux supercalculateurs de l’hypercapitalisme.

De Sentiment à Pluralis, en passant par Sahara AI et Mira, l’objectif de ces projets est de lancer des réseaux permettant à des réseaux décentralisés d’individus de contribuer à l’intelligence des réseaux tout en leur donnant des incitations appropriées.

En compensant cela dans le modèle économique, le taux de croissance de l’open source devrait s’accélérer – offrant aux développeurs et aux chercheurs en IA une alternative mondiale aux grandes entreprises technologiques et la perspective d’être bien rémunérés en fonction de la valeur qu’ils créent.

Même si cela est très difficile à réaliser et que la concurrence est de plus en plus féroce, le marché potentiel est ici énorme.

Modèle GNN

Alors que les grands modèles linguistiques classent les modèles dans de grands corpus de texte et apprennent à prédire le mot suivant, les réseaux neuronaux graphiques (GNN) traitent, analysent et apprennent à partir de données structurées sous forme de graphiques. Étant donné que les données en chaîne sont principalement constituées d'interactions complexes entre les utilisateurs et les contrats intelligents, en d'autres termes, un graphique, les GNN semblent être un choix raisonnable pour prendre en charge les cas d'utilisation de l'IA en chaîne.

Des projets tels que Pond et RPS tentent de créer des modèles de base pour le Web3, qui peuvent être appliqués aux transactions, à la DeFi et même aux cas d'utilisation sociale, tels que :

-

Prévision des prix : les modèles comportementaux en chaîne prédisent les prix, les stratégies de trading automatisées et l'analyse des sentiments

-

Finance IA : intégration avec les applications DeFi existantes, stratégies de rendement avancées et utilisation des liquidités, meilleure gestion/gouvernance des risques

-

Marketing on-chain : airdrops/positionnement plus ciblés, moteur de recommandation basé sur le comportement on-chain

Ces modèles feront largement appel à des solutions d’entreposage de données telles que Space and Time, Subsquid, Covalent et Hyperline, sur lesquelles je suis également très optimiste.

GNN peut prouver que le grand modèle de blockchain et l'entrepôt de données Web3 sont des outils auxiliaires essentiels, c'est-à-dire fournissant des fonctions OLAP (Online Analytical Processing) pour Web3.

application

À mon avis, les agents en chaîne peuvent être la clé pour résoudre le problème de l'expérience utilisateur pour lequel la crypto est bien connue, mais plus important encore, nous avons investi des milliards de dollars dans l'infrastructure Web3 au cours de la dernière décennie, mais l'utilisation du côté de la demande est pitoyable.

Ne vous inquiétez pas, voici les agents…

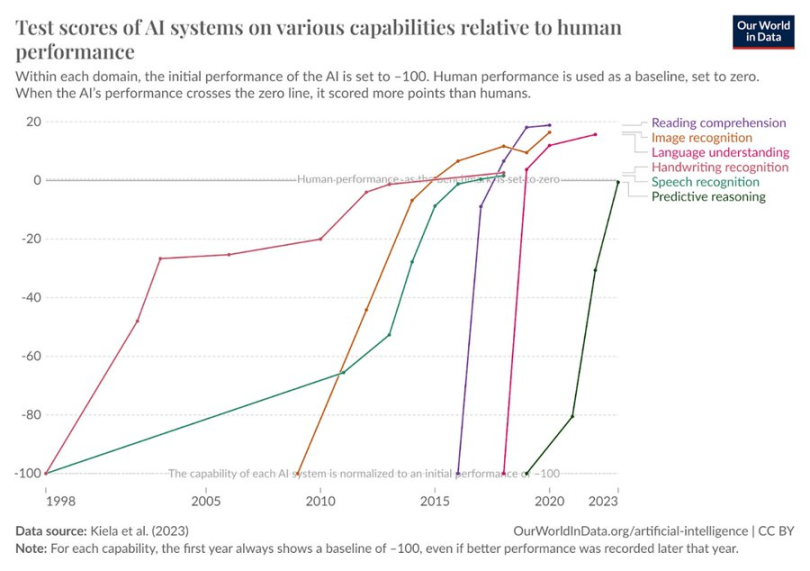

Les résultats des tests d'IA sur diverses dimensions du comportement humain ont augmenté

Il semble logique que ces agents exploitent une infrastructure ouverte et sans autorisation (par le biais des paiements et de l’informatique composable) pour atteindre des objectifs finaux plus complexes. Dans l’économie intelligente en réseau à venir, les flux économiques ne seront peut-être plus B -> B -> C, mais utilisateur -> agent -> réseau informatique -> agent -> utilisateur. Le résultat final de ce flux est le protocole proxy. Les entreprises orientées applications ou services ont des frais généraux limités et exploitent principalement des ressources en chaîne. Le coût de la satisfaction des besoins des utilisateurs finaux (ou des uns des autres) dans un réseau composable est bien inférieur à celui des entreprises traditionnelles. Tout comme la couche applicative du Web2 capture la majeure partie de la valeur, je suis également un partisan de la théorie du protocole proxy lourd dans DeAI. Au fil du temps, la capture de valeur devrait se déplacer vers les couches supérieures de la pile.

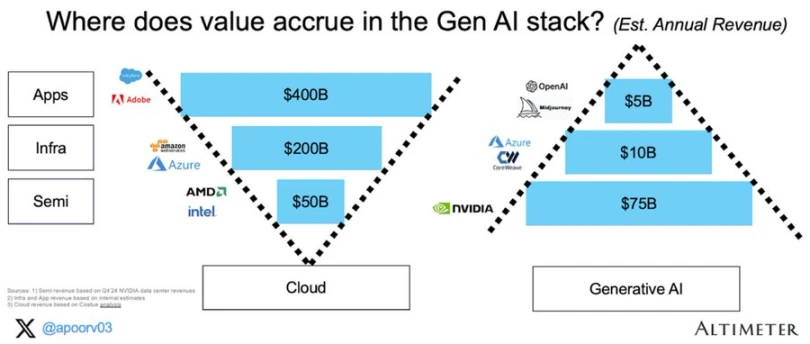

Accumulation de valeur dans l'IA générative

Les prochains Google, Facebook et Blackrock pourraient bien être des protocoles proxy, et les composants pour les mettre en œuvre sont déjà en cours de création.

Fin de partie de DeAI

L’IA va changer notre économie. Aujourd’hui, le marché s’attend à ce que cette capture de valeur soit limitée à quelques grandes entreprises de la côte ouest de l’Amérique du Nord. DeAI représente une vision différente. Une vision ouverte et composable d’un réseau intelligent avec des récompenses et des compensations même pour les plus petites contributions, et une propriété/gestion plus collective.

Bien que certaines des affirmations de DeAI soient exagérées et que de nombreux projets se négocient à des prix nettement supérieurs à leur dynamique actuelle, l'ampleur de l'opportunité est considérable. Pour ceux qui ont la patience et la prévoyance nécessaires, la vision ultime de DeAI d'une informatique véritablement composable peut justifier la blockchain elle-même.

Cet article provient d'Internet : Delphi Digital : Analyse approfondie des opportunités et des défis de DeAI

En lien : Le populaire Polymarket est-il un bon outil de prévision ?

FrançaisArticle original de Felipe Montealegre Traduction originale : Luffy, Foresight News Un jour, un ami et moi discutions du soutien de Robert Kennedy à Trump, et un participant déclara avec assurance que les chances de victoire de Trump avaient augmenté de 2% parce que Polymarket l'avait prédit. C'était une bonne observation car l'événement s'est produit rapidement et il n'y avait pas beaucoup d'autres nouvelles pour faire bouger le marché. Si Polymarket était un marché efficace, cette affirmation semblerait tenable. Le problème est que Polymarket est toujours un marché émergent inefficace qui ne peut pas prédire de petits changements dans la probabilité d'un événement (Le fonctionnement des marchés efficaces est qu'un grand nombre d'investisseurs négocient en fonction des événements. Si vous pensez que le soutien de Robert Kennedy augmentera les chances de Trump de 10%, vous achèterez avec un effet de levier pour…