Né à la périphérie : comment le réseau de puissance de calcul décentralisé renforce-t-il la cryptographie et l'IA ?

Auteur original : Jane Doe, Chen Li

Source primaire: Youbi Capital

1 L'intersection de l'IA et de la crypto

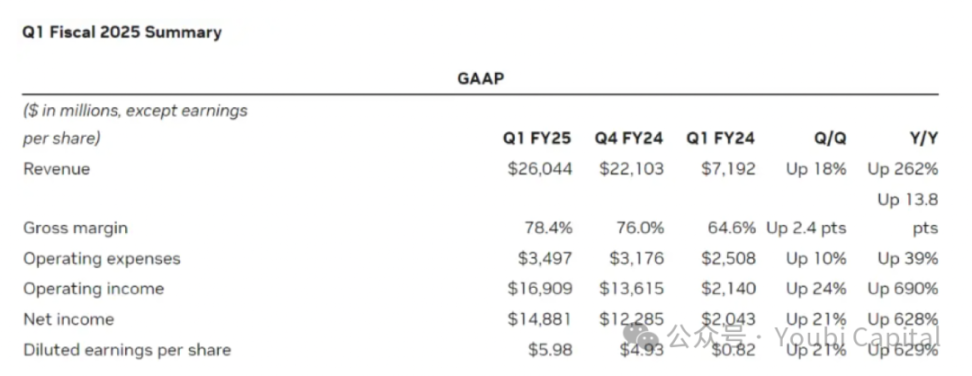

Le 23 mai, le géant des puces électroniques Nvidia a publié son rapport financier du premier trimestre pour l'exercice 2025. Le rapport financier montre que les revenus de Nvidia au premier trimestre se sont élevés à 110 T26 milliards de dollars américains. Parmi eux, les revenus des centres de données ont augmenté de 4 271 T9 milliards de dollars américains par rapport à l'année dernière pour atteindre le chiffre stupéfiant de 110 T22,6 milliards de dollars américains. Derrière les performances financières de Nvidia, qui peuvent à elles seules sauver la bourse américaine, se cache la demande de puissance de calcul qui a explosé parmi les entreprises technologiques mondiales afin de rivaliser sur la piste de l'IA. Plus les grandes entreprises technologiques sont ambitieuses dans leur conception de la piste de l'IA, plus leur demande de puissance de calcul a augmenté de manière exponentielle. Selon les prévisions de TrendForces, en 2024, la demande pour les serveurs d'IA haut de gamme des quatre principaux fournisseurs de services cloud aux États-Unis : Microsoft, Google, AWS et Meta devraient représenter respectivement 20,21 TP9T, 16,61 TP9T, 161 TP9T et 10,81 TP9T de la demande mondiale, pour un total de plus de 601 TP9T.

Source de l'image : https://investor.nvidia.com/financial-info/financial-reports/default.aspx

La pénurie de puces est le mot à la mode depuis plusieurs années. D'une part, la formation et l'inférence de grands modèles linguistiques (LLM) nécessitent une puissance de calcul importante ; et avec l'itération du modèle, le coût et la demande de puissance de calcul augmentent de manière exponentielle. D'autre part, les grandes entreprises comme Meta vont acheter un nombre énorme de puces, et les ressources de puissance de calcul mondiales penchent vers ces géants de la technologie, ce qui rend de plus en plus difficile pour les petites entreprises d'obtenir les ressources de puissance de calcul requises. Les difficultés rencontrées par les petites entreprises ne proviennent pas seulement de l’offre insuffisante de puces provoquée par la forte demande, mais aussi des contradictions structurelles de l’offre. Actuellement, il existe encore un grand nombre de GPU inutilisés du côté de l'offre. Par exemple, certains centres de données disposent d'une grande quantité de puissance de calcul inutilisée (le taux d'utilisation n'est que de 12%-18%), et une grande quantité de ressources de puissance de calcul sont également inutilisées dans le minage de crypto-monnaies en raison de la réduction des bénéfices. Bien que ces puissances de calcul ne soient pas toutes adaptées aux scénarios d'application professionnels tels que la formation à l'IA, le matériel grand public peut néanmoins jouer un rôle majeur dans d'autres domaines tels que l'inférence de l'IA, le rendu de jeux dans le cloud et les téléphones dans le cloud. Les possibilités d'intégrer et d'utiliser cette partie des ressources de puissance de calcul sont énormes.

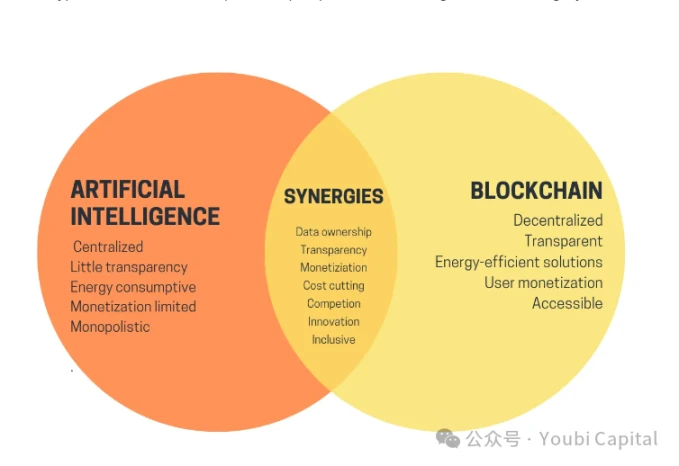

En détournant notre attention de l'IA vers les crypto-monnaies, après trois ans de silence sur le marché des crypto-monnaies, un nouveau marché haussier est enfin arrivé. Les prix du Bitcoin ont atteint de nouveaux sommets et plusieurs memecoins ont émergé les uns après les autres. Bien que l’IA et la cryptographie soient des mots à la mode depuis quelques années, l’intelligence artificielle et la blockchain, en tant que deux technologies importantes, sont comme deux lignes parallèles et n’ont pas encore trouvé de point d’intersection. Au début de cette année, Vitalik a publié un article intitulé « Les promesses et les défis des applications cryptographiques et IA », qui évoque les scénarios futurs de la combinaison de l'IA et des crypto-monnaies. Vitalik a évoqué de nombreuses visions dans l'article, notamment l'utilisation de technologies de cryptage telles que la blockchain et le MPC pour décentraliser la formation et l'inférence de l'IA, ce qui peut ouvrir la boîte noire de l'apprentissage automatique et rendre le modèle d'IA plus fiable, etc. Il reste encore un long chemin à parcourir pour concrétiser ces visions. Mais l’un des cas d’utilisation mentionnés par Vitalik – l’utilisation des crypto-monnaies comme incitations économiques pour renforcer l’IA – est également une direction importante qui peut être réalisée en peu de temps. Le réseau de puissance de calcul décentralisé est l’un des scénarios les plus adaptés à l’IA + crypto à ce stade.

2 Réseau informatique décentralisé

Actuellement, de nombreux projets se développent déjà dans le domaine des réseaux de puissance de calcul décentralisés. La logique sous-jacente de ces projets est similaire, ce qui peut être résumé comme suit : L'utilisation de jetons pour inciter les détenteurs de puissance de calcul à participer au réseau afin de fournir des services de puissance de calcul, et ces ressources de puissance de calcul dispersées peuvent être agrégées dans un réseau de puissance de calcul décentralisé d'une certaine échelle. Cela peut non seulement améliorer le taux d'utilisation de la puissance de calcul inutilisée, mais également répondre aux besoins de puissance de calcul des clients à moindre coût, créant ainsi une situation gagnant-gagnant pour les acheteurs et les vendeurs.

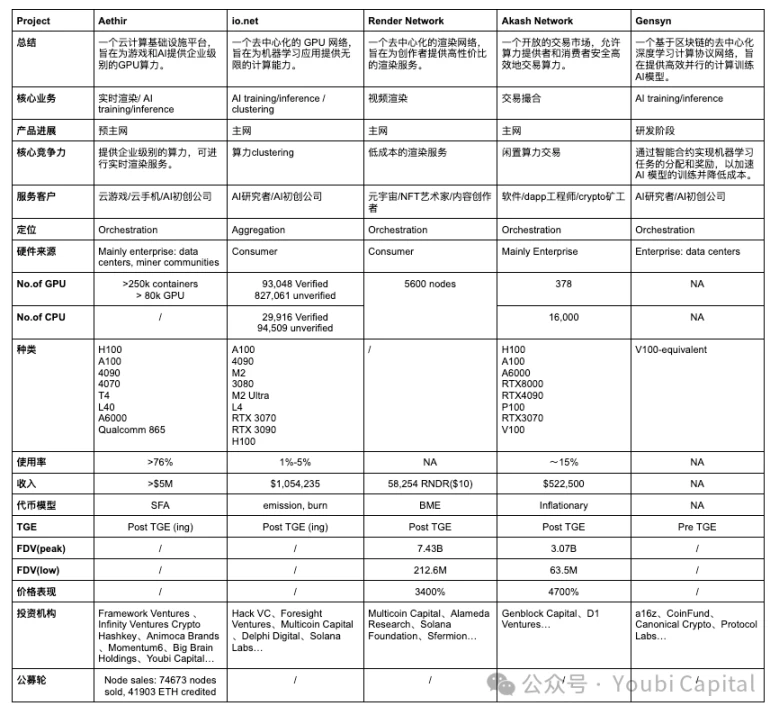

Afin de permettre aux lecteurs d'acquérir une compréhension globale de cette piste en peu de temps, cet article déconstruira des projets spécifiques et la piste entière à partir de deux perspectives : micro et macro, visant à fournir aux lecteurs une perspective analytique pour comprendre les principaux avantages concurrentiels de chaque projet et le développement global de la piste de puissance de calcul décentralisée. L'auteur présentera et analysera cinq projets : Aethir, io.net, réseau de rendu, réseau Akash, Gensyn , et résumer et évaluer l’état du projet et suivre son développement.

Du point de vue du cadre analytique, si nous nous concentrons sur un réseau informatique décentralisé spécifique, nous pouvons le décomposer en quatre composants principaux :

-

Réseau matériel :Il intègre des ressources informatiques dispersées et réalise le partage et l'équilibrage de charge des ressources informatiques via des nœuds répartis dans le monde entier. Il constitue la couche de base du réseau informatique décentralisé.

-

Un marché à deux faces : Associer les fournisseurs de puissance de calcul aux demandeurs grâce à des mécanismes de tarification et de découverte raisonnables, fournir une plateforme de trading sécurisée et garantir que les transactions entre les parties offrantes et demandeuses sont transparentes, équitables et crédibles.

-

Mécanisme de consensus : utilisé pour garantir que les nœuds du réseau fonctionnent correctement et terminent leur travail. Le mécanisme de consensus est principalement utilisé pour surveiller deux niveaux : 1) surveiller si le nœud est en ligne et dans un état actif qui peut accepter des tâches à tout moment ; 2) preuve de travail du nœud : le nœud termine efficacement et correctement la tâche après avoir reçu la tâche, et la puissance de calcul n'est pas utilisée à d'autres fins et occupe des processus et des threads.

-

Incitations symboliques :Le modèle de jeton est utilisé pour inciter davantage de participants à fournir/utiliser des services et à utiliser des jetons pour capturer cet effet de réseau et parvenir à un partage des avantages communautaires.

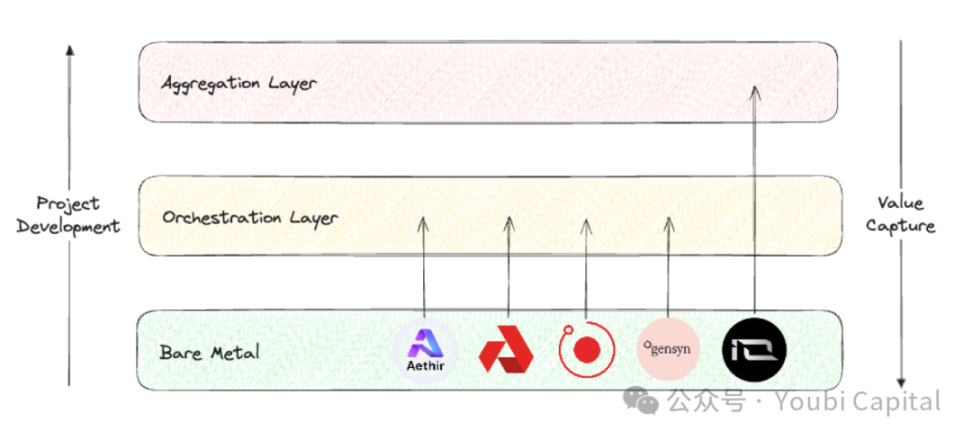

Si nous prenons une vue d'ensemble de l'ensemble de la piste de puissance de calcul décentralisée, le rapport de recherche de Blockworks Research fournit un bon cadre d'analyse. Nous pouvons diviser les positions de projet de cette piste en trois couches différentes.

-

Couche de métal nu :La couche de base de la pile informatique décentralisée. Sa tâche principale est de collecter les ressources informatiques brutes et de les rendre disponibles pour les appels d'API.

-

Couche d'orchestration : La couche intermédiaire de la pile informatique décentralisée. Ses principales tâches sont la coordination et l'abstraction. Il est responsable de la planification, de l'expansion, de l'exploitation, de l'équilibrage de charge et de la tolérance aux pannes de la puissance de calcul. Sa fonction principale est d'abstraire la complexité de la gestion matérielle sous-jacente et de fournir une interface utilisateur plus avancée aux utilisateurs finaux pour servir des groupes de clients spécifiques.

-

Couche d'agrégation :Il constitue la couche supérieure de la pile informatique décentralisée. Sa tâche principale est l'intégration. Il est chargé de fournir une interface unifiée afin que les utilisateurs puissent mettre en œuvre plusieurs tâches informatiques en un seul endroit, telles que la formation de l'IA, le rendu, le zkML, etc. Il est équivalent à la couche d'orchestration et de distribution de plusieurs services informatiques décentralisés.

Source de l'image : Youbi Capital

Sur la base des deux cadres d’analyse ci-dessus, nous ferons une comparaison horizontale des cinq projets sélectionnés et les évaluerons à quatre niveaux : cœur de métier, positionnement sur le marché, installations matérielles et performance financière .

2.1 Cœur de métier

D'après la logique sous-jacente, le réseau informatique décentralisé est hautement homogénéisé, c'est-à-dire qu'il utilise des jetons pour inciter les détenteurs de puissance de calcul inactifs à fournir des services de puissance de calcul. Sur la base de cette logique sous-jacente, nous pouvons comprendre les différences dans le cœur de métier du projet sous trois aspects :

-

Sources de puissance de calcul inutilisée :

-

Il existe deux sources principales de puissance de calcul inutilisée sur le marché : 1) la puissance de calcul inutilisée dans les mains des centres de données, des mineurs et d'autres entreprises ; 2) la puissance de calcul inutilisée dans les mains des investisseurs particuliers. La puissance de calcul des centres de données est généralement constituée de matériel de qualité professionnelle, tandis que les investisseurs particuliers achètent généralement des puces de qualité grand public.

-

La puissance de calcul d'Aethir, Akash Network et Gensyn provient principalement des entreprises. Les avantages de la collecte de la puissance de calcul des entreprises sont les suivants : 1) Les entreprises et les centres de données disposent généralement d'un matériel de meilleure qualité et d'équipes de maintenance professionnelles, et les performances et la fiabilité des ressources de puissance de calcul sont plus élevées ; 2) Les ressources de puissance de calcul des entreprises et des centres de données sont souvent plus homogènes, et la gestion et la surveillance centralisées rendent la planification et la maintenance des ressources plus efficaces. Cependant, cette méthode a également des exigences plus élevées pour la partie projet, et la partie projet doit avoir des relations commerciales avec l'entreprise qui contrôle la puissance de calcul. Dans le même temps, l'évolutivité et la décentralisation seront affectées dans une certaine mesure.

-

Render Network et io.net encouragent principalement les investisseurs particuliers à fournir leur puissance de calcul inutilisée. Les avantages de la collecte de puissance de calcul auprès des investisseurs particuliers sont les suivants : 1) Le coût explicite de la puissance de calcul inutilisée des investisseurs particuliers est faible, ce qui peut fournir des ressources de puissance de calcul plus économiques ; 2) Le réseau est plus évolutif et décentralisé, ce qui améliore l'élasticité et la robustesse du système. L'inconvénient est que les ressources de détail sont largement distribuées et non uniformes, ce qui complique la gestion et la planification et augmente la difficulté d'exploitation et de maintenance. Il est également plus difficile de former un effet de réseau initial en s'appuyant sur la puissance de calcul de détail (plus difficile à démarrer). Enfin, les appareils de détail peuvent présenter davantage de risques de sécurité, ce qui entraînera un risque de fuite de données et d'abus de puissance de calcul.

-

Consommateurs de puissance de calcul

-

Du point de vue des consommateurs de puissance de calcul, les clients cibles d’Aethir, io.net et Gensyn sont principalement des entreprises. Pour les clients B-side, l'IA et le rendu en temps réel des jeux nécessitent des besoins de calcul hautes performances. Ce type de charge de travail a des exigences extrêmement élevées en matière de ressources de puissance de calcul, nécessitant généralement des GPU haut de gamme ou du matériel de qualité professionnelle. De plus, les clients B-side ont des exigences élevées en matière de stabilité et de fiabilité des ressources de puissance de calcul, de sorte que des accords de niveau de service de haute qualité doivent être fournis pour assurer le fonctionnement normal du projet et fournir une assistance technique en temps opportun. Dans le même temps, le coût de migration des clients B-side est très élevé. Si le réseau décentralisé ne dispose pas d'un SDK mature permettant à la partie projet de se déployer rapidement (par exemple, Akash Network oblige les utilisateurs à développer eux-mêmes sur la base de ports distants), il sera difficile pour les clients de migrer. Sans l'avantage de prix extrêmement important, la volonté des clients de migrer serait très faible.

-

Render Network et Akash Network fournissent principalement des services de puissance de calcul aux investisseurs particuliers. Pour fournir des services aux utilisateurs finaux, les projets doivent concevoir des interfaces et des outils simples et faciles à utiliser pour offrir aux consommateurs une bonne expérience client. Les consommateurs sont également très sensibles aux prix, les projets doivent donc proposer des prix compétitifs.

-

Type de matériel

-

Les ressources matérielles informatiques courantes comprennent le CPU, le FPGA, le GPU, l'ASIC et le SoC. Ces matériels présentent des différences significatives en termes d'objectifs de conception, de caractéristiques de performances et de domaines d'application. En résumé, le CPU est meilleur pour les tâches informatiques générales, les avantages des FPGA sont un traitement parallèle élevé et une programmabilité élevée, le GPU fonctionne bien dans le calcul parallèle, l'ASIC est plus efficace dans des tâches spécifiques et le SoC intègre plusieurs fonctions en une seule, adaptée aux applications hautement intégrées. Le choix du matériel dépend des besoins de l'application spécifique, des exigences de performances et des considérations de coût. Les projets de puissance de calcul décentralisée dont nous avons parlé visent principalement à collecter la puissance de calcul du GPU, qui est déterminée par le type d'activité du projet et les caractéristiques du GPU. En effet, le GPU présente des avantages uniques dans la formation de l'IA, le calcul parallèle, le rendu multimédia et d'autres aspects.

-

Bien que la plupart de ces projets impliquent l'intégration de GPU, différentes applications ont des exigences différentes en matière de spécifications matérielles, de sorte que ces matériels ont des cœurs et des paramètres d'optimisation hétérogènes. Ces paramètres incluent le parallélisme/les dépendances série, la mémoire, la latence, etc. Par exemple, les charges de travail de rendu sont en fait plus adaptées aux GPU grand public qu'aux GPU de centre de données plus puissants, car le rendu a des exigences élevées en matière de traçage de rayons, et les puces grand public telles que les 4090 ont des cœurs RT améliorés et sont spécifiquement optimisées pour les tâches de traçage de rayons. La formation et l'inférence de l'IA nécessitent des GPU de niveau professionnel. Par conséquent, Render Network peut collecter des GPU grand public tels que les RTX 3090 et 4090 auprès d'investisseurs particuliers, tandis qu'IO.NET a besoin de GPU de niveau professionnel tels que les H 100 et A 100 pour répondre aux besoins des startups d'IA.

2.2 Positionnement sur le marché

En termes de positionnement du projet, la couche bare metal, la couche d'orchestration et la couche d'agrégation ont des problèmes fondamentaux à résoudre, des axes d'optimisation et des capacités de capture de valeur différents.

-

La couche de métal nu se concentre sur la collecte et l'utilisation des ressources physiques, tandis que la couche d'orchestration se concentre sur la planification et l'optimisation de la puissance de calcul, optimisant la conception du matériel physique en fonction des besoins des groupes de clients. La couche d'agrégation est à usage général, se concentrant sur l'intégration et l'abstraction de différentes ressources. Du point de vue de la chaîne de valeur, chaque projet doit partir de la couche de métal nu et s'efforcer de progresser vers le haut.

-

Du point de vue de la capture de valeur, la capacité à capturer de la valeur augmente couche par couche, de la couche nue, de la couche d’orchestration à la couche d’agrégation. La couche d'agrégation peut capturer le plus de valeur car la plate-forme d'agrégation peut obtenir le plus grand effet réseau et atteindre directement le plus grand nombre d'utilisateurs, ce qui équivaut à l'entrée de trafic du réseau décentralisé, occupant ainsi la position de capture de valeur la plus élevée dans l'ensemble de la pile de gestion des ressources informatiques.

-

En conséquence, la construction d'une plate-forme d'agrégation est la plus difficile. Le projet doit résoudre de manière globale de nombreux problèmes, notamment la complexité technique, la gestion hétérogène des ressources, la fiabilité et l'évolutivité du système, la réalisation de l'effet réseau, la sécurité et la protection de la vie privée, ainsi que la gestion complexe de l'exploitation et de la maintenance. Ces défis ne sont pas propices au démarrage à froid du projet et dépendent du développement et du calendrier de la piste. Il n’est pas réaliste de construire une couche d’agrégation avant que la couche d’orchestration n’ait mûri et occupé une certaine part de marché.

-

Actuellement, Aethir, Render Network, Akash Network et Gensyn appartiennent tous à la couche d'orchestration et sont conçus pour fournir des services à des cibles et des groupes de clients spécifiques. L'activité principale actuelle d'Aethir est le rendu en temps réel pour les jeux en nuage et fournit certains environnements et outils de développement et de déploiement pour les clients B-side ; l'activité principale de Render Networks est le rendu vidéo, la mission d'Akash Networks est de fournir une plateforme de trading similaire à Taobao, et Gensyn est profondément impliqué dans le domaine de la formation à l'IA. io.net se positionne comme une couche d'agrégation, mais les fonctions actuellement implémentées par io sont encore assez éloignées des fonctions complètes de la couche d'agrégation. Bien que le matériel de Render Network et de Filecoin ait été collecté, l'abstraction et l'intégration des ressources matérielles ne sont pas encore terminées.

2.3 Installations matérielles

-

À l'heure actuelle, tous les projets n'ont pas publié de données détaillées sur le réseau. Relativement parlant, l'interface utilisateur de io.net explorer est la meilleure, où vous pouvez voir le nombre, le type, le prix, la distribution, l'utilisation du réseau, les revenus des nœuds et d'autres paramètres du GPU/CPU. Cependant, fin avril, le front-end d'io.net a été attaqué. Comme io n'a pas effectué d'authentification sur l'interface PUT/POST, les pirates ont falsifié les données du front-end. Cela a également sonné l'alarme pour la confidentialité des autres projets et la fiabilité des données du réseau.

-

En termes de nombre et de modèle de GPU, io.net, en tant que couche d'agrégation, aurait dû collecter le plus de matériel. Aethir suit de près, et la situation matérielle des autres projets n'est pas aussi transparente. À partir du modèle de GPU, nous pouvons voir qu'io dispose à la fois de GPU de qualité professionnelle tels que A 100 et de GPU de qualité grand public tels que 4090, avec une grande variété, ce qui est conforme au positionnement de l'agrégation io.net. io peut choisir le GPU le plus adapté en fonction des exigences spécifiques des tâches. Cependant, les GPU de différents modèles et marques peuvent nécessiter des pilotes et des configurations différents, et le logiciel doit également être optimisé de manière complexe, ce qui augmente la complexité de la gestion et de la maintenance. À l'heure actuelle, l'attribution de diverses tâches dans io est principalement basée sur la sélection de l'utilisateur.

-

Aethir a lancé sa propre machine de minage. En mai, Aethir Edge, qui a été développé avec le soutien de Qualcomm, a été officiellement lancé. Il va briser le mode de déploiement centralisé d'un seul cluster GPU loin des utilisateurs et déployer la puissance de calcul vers la périphérie. Aethir Edge combinera la puissance de calcul du cluster H100 pour servir les scénarios d'IA. Il peut déployer des modèles entraînés et fournir aux utilisateurs des services de calcul d'inférence au meilleur coût. Cette solution est plus proche des utilisateurs, fournit des services plus rapides et est plus rentable.

-

Du point de vue de l'offre et de la demande, en prenant Akash Network comme exemple, ses statistiques montrent que le nombre total de CPU est d'environ 16 000 et le nombre de GPU est de 378. Selon la demande de location de réseau, les taux d'utilisation des CPU et des GPU sont respectivement de 11,1% et 19,3%. Parmi eux, seul le GPU professionnel H 100 a un taux de location relativement élevé, et les autres modèles sont pour la plupart inutilisés. La situation à laquelle sont confrontés les autres réseaux est à peu près la même que celle d'Akash. La demande globale pour le réseau n'est pas élevée. À l'exception des puces populaires telles que A 100 et H 100, les autres puissances de calcul sont pour la plupart inutilisées.

-

Du point de vue de l'avantage de prix, à l'exception des géants du marché du cloud computing, l'avantage de coût n'est pas important par rapport aux autres fournisseurs de services traditionnels.

2.4 Performance financière

-

Quel que soit le modèle de jeton conçu, une tokenomics saine doit répondre aux conditions de base suivantes : 1) La demande des utilisateurs pour le réseau doit se refléter dans le prix de la pièce, ce qui signifie que le jeton peut capturer de la valeur ; 2) Tous les participants, qu'il s'agisse de développeurs, de nœuds ou d'utilisateurs, doivent recevoir des incitations à long terme et équitables ; 3) Assurer une gouvernance décentralisée pour éviter les détentions excessives par les initiés ; 4) Des mécanismes d'inflation et de déflation raisonnables et des cycles de libération de jetons pour éviter de fortes fluctuations des prix des pièces qui affectent la robustesse et la durabilité du réseau.

-

Si nous divisons généralement le modèle de jeton en BME (burn and mint equilibrium) et SFA (stake for access), les sources de pression déflationniste sur les jetons de ces deux modèles sont différentes : le modèle BME brûle les jetons après que les utilisateurs aient acheté des services, donc la pression déflationniste du système est déterminée par la demande. Le SFA exige que les fournisseurs de services/nœuds mettent en jeu des jetons pour obtenir la qualification nécessaire pour fournir des services, donc la pression déflationniste est apportée par l'offre. L'avantage du BME est qu'il est plus adapté aux biens non standardisés. Cependant, si la demande pour le réseau est insuffisante, il peut faire face à la pression d'une inflation continue. Les modèles de jetons de divers projets diffèrent dans les détails, mais en général, Aethir préfère SFA, tandis que io.net, Render Network et Akash Network préfèrent BME, et Gensyn est encore inconnu.

-

Du point de vue des revenus, la demande pour le réseau se reflétera directement dans les revenus globaux du réseau (les revenus des mineurs ne sont pas abordés ici, car les mineurs reçoivent des subventions du projet en plus des récompenses pour avoir accompli des tâches). D'après les données publiques, io.net a la valeur la plus élevée. Bien que les revenus d'Aethir n'aient pas encore été annoncés, selon les informations publiques, ils ont annoncé avoir signé des commandes avec de nombreux clients B-side.

-

En termes de prix des pièces, seuls Render Network et Akash Network ont réalisé des ICO. Aethir et io.net ont également récemment émis des pièces, et leur évolution en termes de prix doit être observée, nous n'en parlerons donc pas en détail ici. Le plan de Gensyn n'est pas encore clair. Parmi les deux projets qui ont émis des pièces et les projets qui ont émis des pièces dans la même voie mais qui ne sont pas inclus dans le cadre de cet article, En général, le réseau de puissance de calcul décentralisé présente un rapport prix/performance très impressionnant, ce qui reflète dans une certaine mesure l'énorme potentiel du marché et les attentes élevées de la communauté.

2.5 Résumé

-

Le réseau informatique décentralisé s'est développé rapidement dans son ensemble et de nombreux projets peuvent déjà compter sur des produits pour servir les clients et générer certains revenus. Le réseau s'est éloigné du simple récit et est entré dans une phase de développement où il peut fournir des services préliminaires.

-

La faible demande est un problème courant auquel sont confrontés les réseaux informatiques décentralisés, et la demande des clients à long terme n'a pas été bien vérifiée et explorée. Cependant, la demande n'a pas trop affecté le prix des pièces, et plusieurs projets qui ont déjà émis des pièces ont obtenu de bons résultats.

-

L'intelligence artificielle est le principal moteur du réseau informatique décentralisé, mais elle n'est pas le seul secteur d'activité. En plus d'être utilisée pour la formation et l'inférence de l'IA, la puissance de calcul peut également être utilisée pour le rendu en temps réel de jeux en nuage, de services de téléphonie mobile en nuage, etc.

-

L’hétérogénéité matérielle du réseau de puissance de calcul est relativement élevée, et la qualité et l’échelle du réseau de puissance de calcul doivent être encore améliorées.

-

Pour les utilisateurs finaux C, l'avantage en termes de coût n'est pas très évident. Pour les utilisateurs finaux B, en plus des économies de coûts, ils doivent également prendre en compte la stabilité, la fiabilité, le support technique, la conformité et le support juridique du service, etc., et les projets Web3 ne réussissent généralement pas bien dans ces aspects.

3 Réflexions finales

La croissance explosive de l'IA a créé une demande énorme en puissance de calcul. Depuis 2012, la puissance de calcul utilisée dans les tâches de formation de l'IA a connu une croissance exponentielle, doublant actuellement tous les 3,5 mois (par rapport à la loi de Moore qui double tous les 18 mois). Depuis 2012, la demande en puissance de calcul a été multipliée par plus de 300 000, dépassant de loin la croissance de 12 fois de la loi de Moore. Selon les prévisions, le marché des GPU devrait croître à un taux de croissance annuel composé de 32% pour atteindre plus de 110T200 milliards de TP au cours des cinq prochaines années. L'estimation d'AMD est encore plus élevée, et la société s'attend à ce que le marché des puces GPU atteigne 110T400 milliards de TP d'ici 2027.

Source de l'image : https://www.stateof.ai/

La croissance explosive de l'intelligence artificielle et d'autres charges de travail à forte intensité de calcul (comme le rendu AR/VR) a mis en évidence les inefficacités structurelles du cloud computing traditionnel et des principaux marchés informatiques. En théorie, les réseaux informatiques décentralisés peuvent fournir des solutions plus flexibles, moins coûteuses et plus efficaces en utilisant des ressources informatiques inactives distribuées, répondant ainsi à l'énorme demande du marché en ressources informatiques. Par conséquent, la combinaison de la cryptographie et de l'IA a un énorme potentiel de marché, mais elle est également confrontée à une concurrence féroce de la part des entreprises traditionnelles, à des barrières à l'entrée élevées et à un environnement de marché complexe. En général, en examinant toutes les pistes de cryptographie, les réseaux informatiques décentralisés sont l’un des secteurs verticaux les plus prometteurs dans le domaine de la cryptographie, capable de répondre à des besoins réels.

Source de l'image : https://vitalik.eth.limo/general/2024/01/30/cryptoai.html

L'avenir est prometteur, mais le chemin est tortueux. Pour concrétiser cette vision, nous devons encore résoudre de nombreux problèmes et relever de nombreux défis. En résumé : À ce stade, si nous ne fournissons que des services cloud traditionnels, la marge bénéficiaire du projet est très faible. Du côté de la demande, les grandes entreprises construisent généralement leur propre puissance de calcul, et les développeurs C-end purs choisissent principalement les services cloud. Il reste encore à explorer et à vérifier si les petites et moyennes entreprises qui utilisent réellement les ressources du réseau de puissance de calcul décentralisé auront une demande stable. D'autre part, l'IA est un vaste marché avec une limite supérieure et une marge d'imagination très élevées. Pour un marché plus large, les fournisseurs de services de puissance de calcul décentralisés devront également se transformer en services de modélisation/IA à l'avenir, explorer davantage de scénarios d'utilisation de la cryptographie + IA et étendre la valeur que le projet peut créer. Mais à l'heure actuelle, il reste encore de nombreux problèmes et défis à développer davantage dans le domaine de l'IA :

-

L'avantage de prix n'est pas exceptionnel :La comparaison des données précédentes montre que l'avantage de coût du réseau informatique décentralisé n'a pas été reflété. La raison possible est que pour les puces professionnelles telles que H100 et A100, qui sont très demandées, le mécanisme du marché détermine que le prix de cette partie du matériel ne sera pas bon marché. De plus, bien que le réseau décentralisé puisse collecter des ressources informatiques inutilisées, le manque d'économies d'échelle apporté par la décentralisation, les coûts élevés du réseau et de la bande passante, ainsi que la gestion et l'exploitation et la maintenance extrêmement complexes augmenteront encore le coût de calcul.

-

La particularité de la formation de l'IA :Il existe d'énormes goulots d'étranglement techniques dans la phase actuelle de formation de l'IA de manière décentralisée. Ce goulot d'étranglement peut être reflété intuitivement dans le flux de travail du GPU. Lors de la formation de grands modèles de langage, le GPU reçoit d'abord les lots de données prétraités et effectue des calculs de propagation avant et arrière pour générer des gradients. Ensuite, chaque GPU agrège les gradients et met à jour les paramètres du modèle pour garantir que tous les GPU sont synchronisés. Ce processus sera répété jusqu'à ce que tous les lots de formation soient terminés ou que le nombre prédéterminé de tours soit atteint. Ce processus implique une grande quantité de transmission et de synchronisation de données. Le type de stratégies parallèles et de synchronisation à utiliser, comment optimiser la bande passante et la latence du réseau et réduire les coûts de communication, etc., n'ont pas encore été bien résolus. À ce stade, il n'est pas très réaliste d'utiliser un réseau de puissance de calcul décentralisé pour former l'IA.

-

Sécurité et confidentialité des données :Lors de la formation de grands modèles linguistiques, tous les aspects du traitement et de la transmission des données, tels que la distribution des données, la formation des modèles, l'agrégation des paramètres et des gradients, peuvent affecter la sécurité et la confidentialité des données. En outre, la confidentialité des données est plus importante que la confidentialité des modèles. Si le problème de la confidentialité des données ne peut pas être résolu, il ne sera pas possible d'augmenter véritablement la demande.

D'un point de vue réaliste, un réseau informatique décentralisé doit prendre en compte à la fois la découverte de la demande actuelle et l'espace de marché futur. Trouvez le bon positionnement de produit et ciblez les groupes de clients, par exemple en ciblant d'abord les projets non IA ou natifs du Web3, en commençant par des besoins relativement marginaux et en créant une base d'utilisateurs précoce. Dans le même temps, continuez à explorer divers scénarios combinant IA et crypto, explorez l'avant-garde de la technologie et réalisez la transformation et la mise à niveau des services.

Les références

https://vitalik.eth.limo/general/2024/01/30/cryptoai.html

https://foresightnews.pro/article/detail/34368

https://research.web3 caff.com/zh/archives/17351?ref=1554

Cet article provient d'Internet : Né à la périphérie : comment le réseau de puissance de calcul décentralisé renforce-t-il la cryptographie et l'IA ?

Source originale : Chain Teahouse 1. Présentation du projet io.net est un système GPU distribué basé sur Solana, Render, Ray et Filecoin, conçu pour exploiter les ressources GPU distribuées afin de résoudre les défis informatiques dans les domaines de l'IA et de l'apprentissage automatique. io.net résout le problème des ressources informatiques insuffisantes en agrégeant les ressources informatiques sous-utilisées telles que les centres de traitement de données indépendants, les mineurs de crypto-monnaie et les GPU excédentaires des projets cryptographiques tels que Filecoin et Render, permettant aux ingénieurs d'obtenir de grandes quantités de puissance de calcul dans un système facilement accessible, personnalisable et peu coûteux. De plus, io.net introduit un réseau d'infrastructure physique distribué (depin), combinant des ressources provenant de divers fournisseurs pour permettre aux ingénieurs d'accéder à des quantités massives de puissance de calcul d'une manière personnalisable, rentable et facile à mettre en œuvre. io cloud compte désormais plus de 95 000 GPU et plus…