Delphi Digital: Análisis en profundidad de las oportunidades y desafíos de DeAI

Autor original: PonderingDurian, investigador digital de Delphi

Traducción original: Pzai, Foresight News

Dado que las criptomonedas son esencialmente software de código abierto con incentivos económicos incorporados, y que la IA está alterando la forma en que se escribe el software, la IA tendrá un impacto enorme en todo el espacio blockchain.

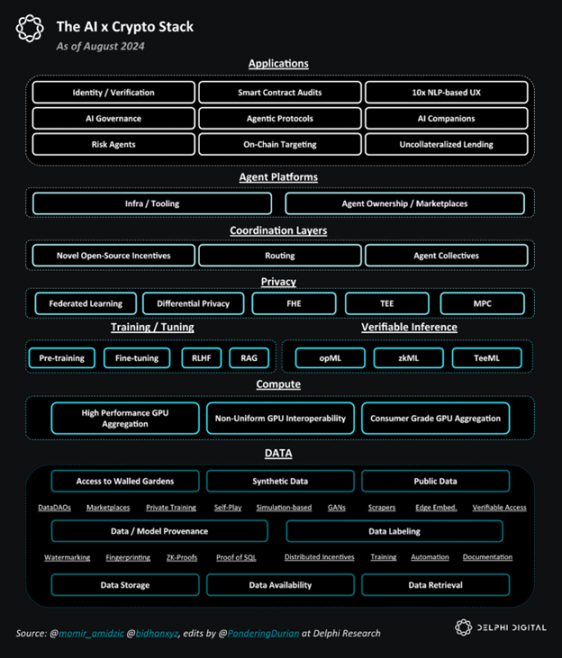

Pila general de IA y criptografía

DeAI: oportunidades y desafíos

En mi opinión, el mayor desafío que enfrenta DeAI radica en la capa de infraestructura, porque construir modelos básicos requiere mucho capital y los retornos a escala para los datos y la computación también son altos.

Dada la ley de escalabilidad, los gigantes tecnológicos tienen una ventaja natural: habiendo obtenido enormes ganancias de los beneficios monopólicos de la agregación de la demanda de los consumidores durante la fase Web2 y habiendo reinvertido esas ganancias en infraestructura en la nube durante una década de tarifas artificialmente bajas, los gigantes de Internet ahora están tratando de capturar el mercado de la IA dominando los datos y la computación (elementos clave de la IA):

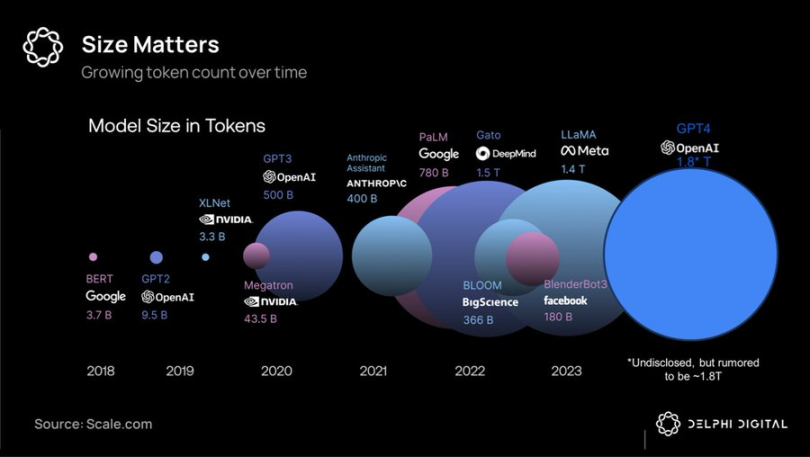

Simbólico Comparación de volumen de modelos grandes

Debido a la intensidad de capital y los altos requisitos de ancho de banda del entrenamiento a gran escala, los supercúmulos unificados siguen siendo la mejor opción, ya que brindan a los gigantes tecnológicos los modelos de código cerrado de mejor rendimiento, que planean alquilar con ganancias monopólicas y reinvertir las ganancias en cada generación posterior de productos.

Sin embargo, resulta que el foso en el campo de la IA es más superficial que el efecto de red Web2, y los modelos de vanguardia líderes se están depreciando rápidamente en relación con el campo, especialmente porque Meta ha adoptado una política de tierra arrasada e invertido decenas de miles de millones de dólares para desarrollar modelos de vanguardia de código abierto como Llama 3.1, cuyo rendimiento ha alcanzado niveles SOTA.

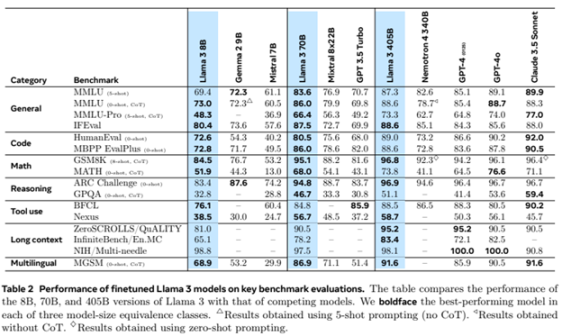

Calificación del modelo grande Llama 3

En este punto, combinado con la investigación emergente sobre métodos de entrenamiento descentralizado de baja latencia, podría mercantilizar (partes de) modelos comerciales de vanguardia: a medida que caen los precios de los teléfonos inteligentes, la competencia se trasladaría (al menos parcialmente) de los supercúmulos de hardware (que favorecen a los gigantes tecnológicos) a la innovación de software (que favorece ligeramente al código abierto/criptomonedas).

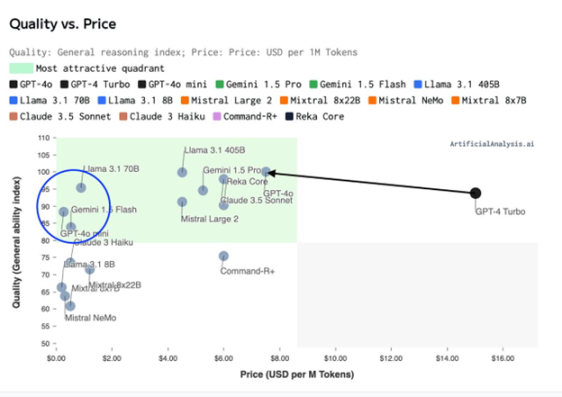

Índice de capacidad (calidad) – Cuadro de distribución de precios de capacitación

Dada la eficiencia computacional de las arquitecturas de “mezcla de expertos” y la síntesis y el enrutamiento de modelos de gran tamaño, es probable que no nos enfrentemos a un mundo de 3 a 5 modelos gigantes, sino a un mundo de millones de modelos con diferentes compensaciones de costo/rendimiento. Una red (colmena) de inteligencia entrelazada.

Esto plantea un enorme problema de coordinación, un problema que los mecanismos de incentivos de blockchain y criptomonedas deberían poder ayudar a resolver muy bien.

Áreas de inversión principales de DeAI

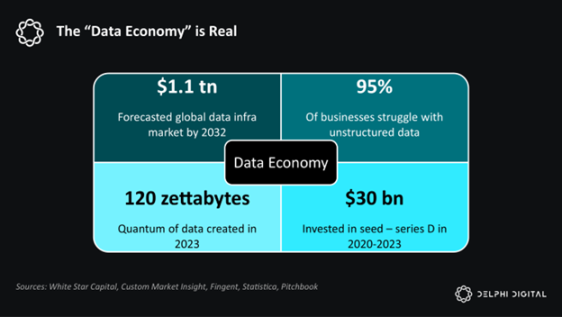

El software se está comiendo al mundo. La IA se está comiendo al software. Y la IA es básicamente datos y computación.

Delphi es optimista sobre los componentes de esta pila:

Simplificando la pila de IA y criptografía

Infraestructura

Dado que la IA se alimenta de datos y computación, la infraestructura de DeAI se centra en obtener datos y computación de la manera más eficiente posible, a menudo utilizando incentivos de criptomonedas. Como mencionamos anteriormente, esta es la parte más desafiante de la competencia, pero dado el tamaño del mercado final, también puede ser la parte más gratificante.

calcular

Los protocolos de entrenamiento distribuido y el mercado de GPU se han visto limitados por retrasos hasta ahora, pero esperan coordinar el potencial del hardware heterogéneo para proporcionar servicios informáticos a demanda y de menor costo a quienes están excluidos de las soluciones integradas de los gigantes. Empresas como Gensyn, Prime Intellect y Neuromesh están impulsando el desarrollo del entrenamiento distribuido, mientras que empresas como io.net, Akash, Aethir y otras están permitiendo una inferencia de bajo costo más cercana a la inteligencia de borde.

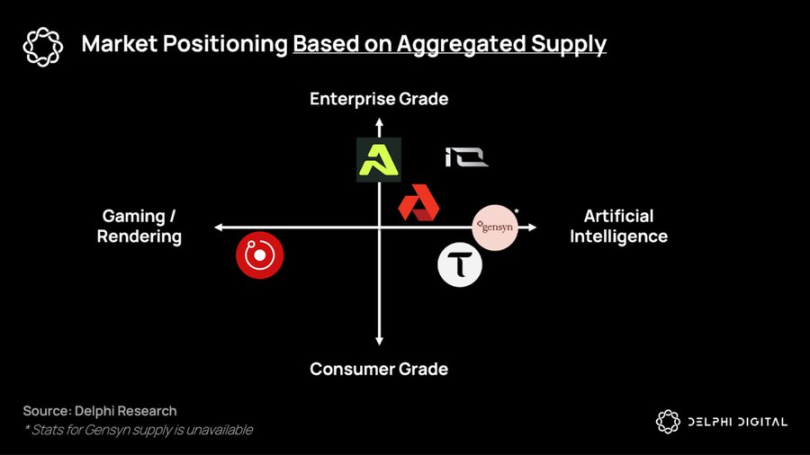

Distribución de nichos de proyectos en función de la oferta agregada

datos

En un mundo de inteligencia ubicua basada en modelos más pequeños y especializados, los activos de datos son cada vez más valiosos y monetizables.

Hasta la fecha, DePIN ha sido ampliamente elogiada por su capacidad de construir redes de hardware a un costo menor que el de las empresas con uso intensivo de capital, como las de telecomunicaciones. Sin embargo, el mayor mercado potencial para DePIN será la recopilación de nuevos tipos de conjuntos de datos que fluirán hacia sistemas inteligentes en cadena: protocolos proxy (que se analizarán más adelante).

En un mundo donde el mercado potencial más grande del mundo –la mano de obra– está siendo reemplazado por datos y computación, la infraestructura de IA proporciona una forma para que las personas no técnicas aprovechen los medios de producción y contribuyan a la próxima economía en red.

software intermedio

El objetivo final de DeAI es permitir una computación componible eficiente. Como el Lego capital de DeFi, DeAI compensa la falta de rendimiento absoluto actual mediante la componibilidad sin permisos, incentivando un ecosistema abierto de software y primitivos informáticos para que sigan componiéndose con el tiempo, superando así (con suerte) al software y los primitivos informáticos existentes.

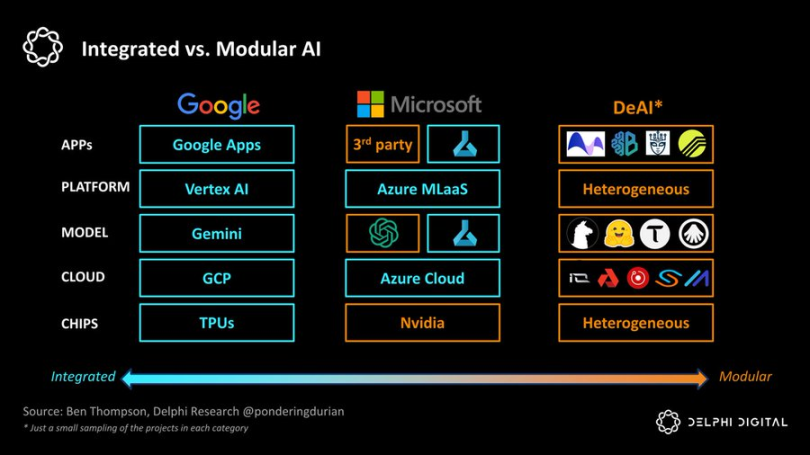

Si Google es el extremo de la “integración”, DeAI representa el extremo de la “modularización”. Como nos recuerda Clayton Christensen, en las industrias emergentes, los enfoques integrados tienden a ser los primeros en reducir la fricción en la cadena de valor, pero a medida que el campo madura, las cadenas de valor modulares ganan terreno al aumentar la competencia y la eficiencia de costos en cada capa de la pila:

IA integrada vs. IA modular

Somos muy optimistas en varias categorías que son fundamentales para lograr esta visión modular:

enrutamiento

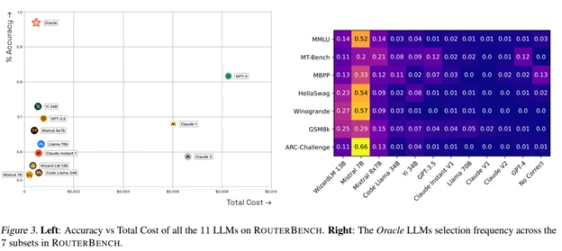

En un mundo de inteligencia fragmentada, ¿cómo podemos elegir el modo y el momento adecuados al mejor precio? Los agregadores del lado de la demanda siempre han capturado valor (véase la teoría de agregación), y las funciones de enrutamiento son fundamentales para optimizar la curva de Pareto entre el rendimiento y el costo en un mundo de inteligencia en red:

Bittensor ha estado a la vanguardia de la primera generación de productos, pero han surgido varios competidores dedicados.

Allora organiza competiciones entre diferentes modelos en distintos “temas” de una manera “consciente del contexto” y que se mejora a sí misma a lo largo del tiempo, informando predicciones futuras basadas en su precisión histórica en condiciones específicas.

Morpheus apunta a ser el “enrutamiento del lado de la demanda” para los casos de uso de Web3, esencialmente una “inteligencia de Apple” con un proxy local de código abierto que entiende el contexto relevante del usuario y puede enrutar consultas de manera eficiente a través de bloques de construcción emergentes de DeFi o la infraestructura de “computación componible” de Web3.

Los protocolos de interoperabilidad de agentes como Theoriq y Autonolas apuntan a llevar el enrutamiento modular al extremo, permitiendo que un ecosistema compuesto y componible de agentes o componentes flexibles se convierta en un servicio en cadena completamente maduro.

En resumen, en un mundo en el que la inteligencia se fragmenta rápidamente, los agregadores de la oferta y la demanda serán extremadamente poderosos. Si Google es una empresa de $2 millones que indexa la información del mundo, entonces el ganador del enrutador de la demanda (ya sea Apple, Google o una solución Web3) la empresa que indexe la inteligencia proxy tendrá una escala mucho mayor.

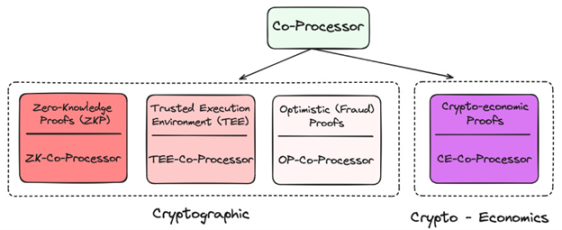

Coprocesador

Dada su naturaleza descentralizada, la cadena de bloques está muy limitada tanto en términos de datos como de computación. ¿Cómo se pueden incorporar a la cadena de bloques las aplicaciones de inteligencia artificial que consumen muchos datos y computación? ¡Mediante coprocesadores!

Capa de aplicación del coprocesador en Crypto

Todos ellos proporcionan diferentes técnicas para verificar que los datos o el modelo subyacentes que se utilizan son un oráculo válido, lo que minimiza los nuevos supuestos de confianza en la cadena y, al mismo tiempo, mejora enormemente sus capacidades. Hasta la fecha, muchos proyectos han utilizado zkML, opML, TeeML y métodos criptoeconómicos, y sus ventajas y desventajas varían:

Comparación de coprocesadores

En un nivel superior, los coprocesadores son fundamentales para la inteligencia de los contratos inteligentes: brindan una solución similar a un “almacén de datos” para realizar consultas para lograr una experiencia en cadena más personalizada o para verificar que una determinada inferencia se completó correctamente.

Las redes TEE (Trusted Execution) como Super, Phala y Marlin se han vuelto cada vez más populares recientemente debido a su practicidad y capacidad para alojar aplicaciones a gran escala.

En general, los coprocesadores son fundamentales para fusionar cadenas de bloques de alto nivel determinista pero de bajo rendimiento con agentes de alto rendimiento pero probabilísticos. Sin coprocesadores, la IA no estaría presente en esta generación de cadenas de bloques.

Incentivos para desarrolladores

Uno de los mayores problemas del desarrollo de código abierto en IA es la falta de incentivos para que sea sostenible. El desarrollo de IA requiere una gran inversión de capital y los costos de oportunidad tanto de la computación como del conocimiento de IA son muy altos. Sin los incentivos adecuados para recompensar las contribuciones de código abierto, el campo inevitablemente perderá terreno frente a las supercomputadoras del hipercapitalismo.

Desde Sentiment hasta Pluralis, Sahara AI y Mira, el objetivo de estos proyectos es lanzar redes que permitan que redes descentralizadas de individuos contribuyan a la inteligencia de las redes y al mismo tiempo les brinden incentivos apropiados.

Al compensar esto con el modelo de negocios, la tasa de crecimiento compuesto del código abierto debería acelerarse, brindando a los desarrolladores e investigadores de IA una alternativa global a las grandes empresas tecnológicas y la perspectiva de recibir una buena compensación en función del valor que crean.

Si bien es muy difícil hacerlo y la competencia es cada vez más feroz, el mercado potencial aquí es enorme.

Modelo GNN

Mientras que los modelos de lenguaje de gran tamaño clasifican patrones en grandes corpus de texto y aprenden a predecir la siguiente palabra, las redes neuronales gráficas (GNN) procesan, analizan y aprenden de datos estructurados en grafos. Dado que los datos en cadena consisten principalmente en interacciones complejas entre usuarios y contratos inteligentes, es decir, un grafo, las GNN parecen ser una opción razonable para respaldar los casos de uso de IA en cadena.

Projects such as Pond and RPS are trying to build basic models for web3, which may be applied in transactions, DeFi and even social use cases, such as:

-

Predicción de precios: modelos de comportamiento en cadena predicen precios, estrategias comerciales automatizadas, análisis de sentimientos

-

Finanzas con inteligencia artificial: integración con aplicaciones DeFi existentes, estrategias avanzadas de rendimiento y utilización de liquidez, mejor gestión y gobernanza de riesgos

-

Marketing en cadena: airdrops/posicionamiento más específicos, motor de recomendaciones basado en el comportamiento en cadena

Estos modelos harán un uso intensivo de soluciones de almacenamiento de datos como Space and Time, Subsquid, Covalent y Hyperline, sobre las que también soy muy optimista.

GNN puede demostrar que el gran modelo de blockchain y el almacén de datos Web3 son herramientas auxiliares esenciales, es decir, proporcionan funciones OLAP (procesamiento analítico en línea) para Web3.

solicitud

En mi opinión, los agentes en cadena pueden ser la clave para resolver el problema de la experiencia del usuario por el cual las criptomonedas son bien conocidas, pero lo que es más importante, hemos invertido miles de millones de dólares en infraestructura Web3 durante la última década, pero la utilización en el lado de la demanda es lamentable.

No os preocupéis, aquí vienen los agentes…

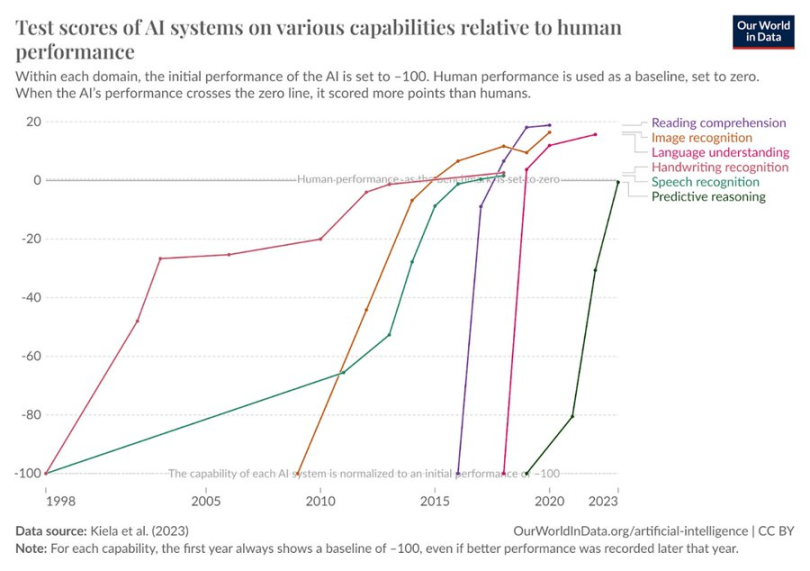

Los resultados de las pruebas de IA en varias dimensiones del comportamiento humano han aumentado

Parece lógico que estos agentes aprovechen la infraestructura abierta y sin permisos (a través de pagos y computación componible) para lograr objetivos finales más complejos. En la futura economía inteligente en red, los flujos económicos ya no serán B -> B -> C, sino usuario -> agente -> red informática -> agente -> usuario. El resultado final de este flujo es el protocolo proxy. Las empresas orientadas a aplicaciones o servicios tienen una sobrecarga limitada y ejecutan principalmente recursos en cadena. El costo de satisfacer las necesidades de los usuarios finales (o de los demás) en una red componible es mucho menor que el de las empresas tradicionales. Así como la capa de aplicación de la Web2 captura la mayor parte del valor, también soy partidario de la teoría del protocolo proxy gordo en DeAI. Con el tiempo, la captura de valor debería trasladarse a las capas superiores de la pila.

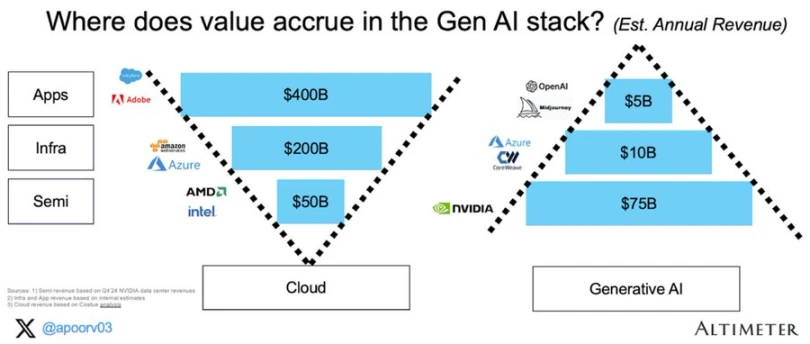

Acumulación de valor en la IA generativa

Los próximos Google, Facebook y Blackrock bien podrían ser protocolos proxy, y los componentes para implementarlos ya se están creando.

Final del juego de DeAI

La IA cambiará nuestra economía. Hoy, el mercado espera que esta captura de valor se limite a unas pocas grandes empresas de la costa oeste de Norteamérica. DeAI representa una visión diferente: una visión abierta y componible de una red inteligente con recompensas y compensaciones incluso para las contribuciones más pequeñas, y una propiedad y gestión más colectivas.

Si bien algunas de las afirmaciones de DeAI son exageradas y muchos proyectos se comercializan a precios significativamente más altos que su impulso real actual, la escala de la oportunidad es significativa. Para quienes tengan paciencia y previsión, la visión definitiva de DeAI de una computación verdaderamente componible puede justificar la propia blockchain.

Este artículo procede de Internet: Delphi Digital: Análisis en profundidad de las oportunidades y desafíos de DeAI

Relacionado: ¿Es el popular Polymarket una buena herramienta de pronóstico?

Artículo original de Felipe Montealegre Traducción original: Luffy, Foresight News Una vez, un amigo y yo estábamos discutiendo sobre el respaldo de Robert Kennedy a Trump, y un participante declaró con confianza que las posibilidades de Trump de ganar habían aumentado en 2% porque Polymarket así lo predijo. Esta fue una buena observación porque el evento ocurrió rápidamente y no hubo muchas otras noticias que movieran el mercado. Si Polymarket fuera un mercado eficiente, esta afirmación parecería ser sostenible. El problema es que Polymarket sigue siendo un mercado emergente ineficiente que no puede predecir pequeños cambios en la probabilidad de un evento (la forma en que funcionan los mercados eficientes es que una gran cantidad de inversores negocian en función de los eventos). Si cree que el respaldo de Robert Kennedy aumentará las probabilidades de Trump en 10%, comprará con apalancamiento para…