Am Rand geboren: Wie stärkt das dezentrale Rechenleistungsnetzwerk Krypto und KI?

Originalautor: Jane Doe, Chen Li

Originalquelle: Youbi-Kapital

1 Die Schnittstelle zwischen KI und Krypto

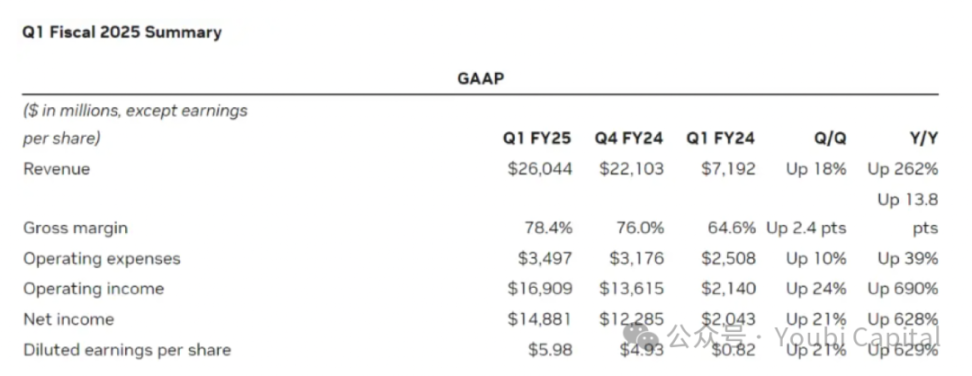

Am 23. Mai veröffentlichte der Chip-Riese Nvidia seinen Finanzbericht für das erste Quartal des Geschäftsjahres 2025. Der Finanzbericht zeigt, dass der Umsatz von Nvidia im ersten Quartal $26 Milliarden US-Dollar betrug. Darunter stieg der Umsatz im Rechenzentrumsgeschäft im Vergleich zum Vorjahr um 427% auf unglaubliche $22,6 Milliarden US-Dollar. Hinter Nvidias finanzieller Leistung, die den US-Aktienmarkt allein retten kann, steht die explodierte Nachfrage nach Rechenleistung bei globalen Technologieunternehmen, um im KI-Bereich wettbewerbsfähig zu sein. Je ehrgeiziger die Top-Technologieunternehmen bei der Gestaltung des KI-Bereichs sind, desto mehr ist ihre Nachfrage nach Rechenleistung exponentiell gestiegen. Laut TrendForces-Prognose wird die Nachfrage im Jahr 2024 Die Nachfrage nach High-End-KI-Servern der vier großen Cloud-Dienstanbieter in den USA, Microsoft, Google, AWS und Meta, dürfte 20,21 TP9T, 16,61 TP9T, 161 TP9T bzw. 10,81 TP9T der weltweiten Nachfrage ausmachen, was insgesamt mehr als 601 TP9T entspricht.

Bildquelle: https://investor.nvidia.com/financial-info/financial-reports/default.aspx

Chipmangel ist seit mehreren Jahren das alljährliche Schlagwort. Einerseits erfordern das Training und die Inferenz großer Sprachmodelle (LLMs) eine Menge Rechenleistung; und mit der Iteration des Modells steigen die Kosten und der Bedarf an Rechenleistung exponentiell. Andererseits kaufen große Unternehmen wie Meta eine riesige Anzahl von Chips, und die globalen Rechenleistungsressourcen sind auf diese Technologiegiganten ausgerichtet, was es für kleine Unternehmen zunehmend schwieriger macht, die erforderlichen Rechenleistungsressourcen zu erhalten. Die Schwierigkeiten kleinerer Unternehmen resultieren nicht nur aus der durch die gestiegene Nachfrage bedingten Unterversorgung mit Chips, sondern auch aus strukturellen Widersprüchen im Angebot. Derzeit gibt es auf der Angebotsseite noch eine große Anzahl ungenutzter GPUs. Beispielsweise verfügen einige Rechenzentren über eine große Menge ungenutzter Rechenleistung (die Auslastungsrate beträgt nur 12%-18%), und auch beim Krypto-Mining liegen aufgrund sinkender Gewinne viele Rechenleistungsressourcen ungenutzt. Obwohl diese Rechenleistung nicht für professionelle Anwendungsszenarien wie KI-Training geeignet ist, kann Hardware für Verbraucher in anderen Bereichen wie KI-Inferenz, Cloud-Game-Rendering und Cloud-Telefonen dennoch eine große Rolle spielen. Die Möglichkeit, diesen Teil der Rechenleistungsressourcen zu integrieren und zu nutzen, ist riesig.

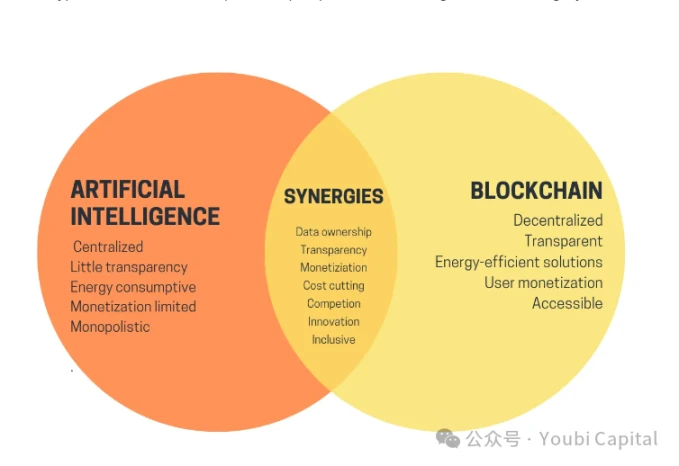

Wenn wir unsere Aufmerksamkeit von der KI auf Kryptowährungen richten, ist nach drei Jahren Stille auf dem Kryptowährungsmarkt endlich ein neuer Bullenmarkt eingekehrt. Die Bitcoin-Preise haben neue Höchststände erreicht und nacheinander sind verschiedene Memecoins aufgetaucht. Obwohl KI und Krypto in den letzten Jahren zu beliebten Schlagworten geworden sind, verlaufen künstliche Intelligenz und Blockchain als zwei wichtige Technologien wie zwei parallele Linien und haben noch keinen Schnittpunkt gefunden. Anfang dieses Jahres veröffentlichte Vitalik einen Artikel mit dem Titel „Das Versprechen und die Herausforderungen von Krypto- und KI-Anwendungen“, in dem er die Zukunftsszenarien der Kombination von KI und Krypto diskutierte. Vitalik erwähnte in dem Artikel viele Visionen, darunter die Verwendung von Verschlüsselungstechnologien wie Blockchain und MPC, um das Training und die Inferenz von KI zu dezentralisieren, was die Blackbox des maschinellen Lernens öffnen und das KI-Modell vertrauenswürdiger machen kann usw. Es ist noch ein langer Weg, diese Visionen zu verwirklichen. Aber einer der von Vitalik erwähnten Anwendungsfälle – die Nutzung wirtschaftlicher Anreize durch Kryptowährungen zur Stärkung der KI – ist ebenfalls eine wichtige Richtung, die in kurzer Zeit umgesetzt werden kann. Das dezentrale Rechenleistungsnetzwerk ist derzeit eines der am besten geeigneten Szenarien für KI + Kryptowährung.

2 Dezentrales Computernetzwerk

Derzeit gibt es bereits viele Projekte im Bereich dezentraler Rechenleistungsnetze. Die zugrunde liegende Logik dieser Projekte ist ähnlich und kann wie folgt zusammengefasst werden: Durch die Verwendung von Token werden Rechenleistungsinhaber dazu motiviert, am Netzwerk teilzunehmen und Rechenleistungsdienste bereitzustellen. Diese verstreuten Rechenleistungsressourcen können zu einem dezentralen Rechenleistungsnetzwerk einer bestimmten Größenordnung zusammengefasst werden. Dadurch kann nicht nur die Auslastung ungenutzter Rechenleistung verbessert, sondern auch der Rechenleistungsbedarf der Kunden zu geringeren Kosten gedeckt werden, wodurch eine Win-Win-Situation für Käufer und Verkäufer entsteht.

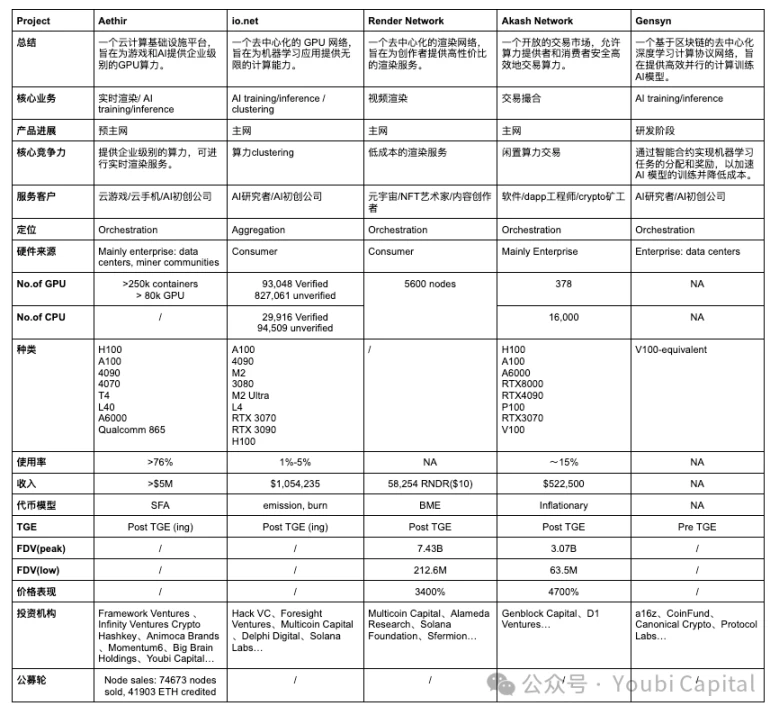

Damit die Leser in kurzer Zeit ein Gesamtverständnis dieses Tracks erlangen können, werden in diesem Artikel bestimmte Projekte und der gesamte Track aus zwei Perspektiven dekonstruiert: Mikro und Makro. Ziel ist es, den Lesern eine analytische Perspektive zu bieten, um die wesentlichen Wettbewerbsvorteile jedes Projekts und die Gesamtentwicklung des Tracks zur dezentralen Rechenleistung zu verstehen. Der Autor wird fünf Projekte vorstellen und analysieren: Aethir, io.net, Render Network, Akash Network, Gensyn , fassen Sie den Projektstatus zusammen, bewerten Sie ihn und verfolgen Sie die Entwicklung.

Wenn wir uns aus der Perspektive des analytischen Rahmens auf ein bestimmtes dezentrales Computernetzwerk konzentrieren, können wir es in vier Kernkomponenten unterteilen:

-

Hardware-Netzwerk : Es integriert verstreute Computerressourcen und realisiert die gemeinsame Nutzung und den Lastausgleich von Computerressourcen über weltweit verteilte Knoten. Es ist die Basisschicht des dezentralen Computernetzwerks.

-

Zweiseitiger Markt : Bringen Sie Anbieter von Rechenleistung durch angemessene Preis- und Beschaffungsmechanismen mit Nachfragern zusammen, stellen Sie eine sichere Handelsplattform bereit und gewährleisten Sie, dass die Transaktionen zwischen Angebot und Nachfrage transparent, fair und glaubwürdig sind.

-

Konsensmechanismus : Wird verwendet, um sicherzustellen, dass Knoten im Netzwerk ordnungsgemäß ausgeführt werden und ihre Arbeit abschließen. Der Konsensmechanismus wird hauptsächlich zur Überwachung auf zwei Ebenen verwendet: 1) Überwachen, ob der Knoten online und in einem aktiven Zustand ist, der jederzeit Aufgaben annehmen kann; 2) Knotenarbeitsnachweis: Der Knoten führt die Aufgabe nach Erhalt der Aufgabe effektiv und korrekt aus, und die Rechenleistung wird nicht für andere Zwecke verwendet und belegt Prozesse und Threads.

-

Token-Anreize : Das Token-Modell wird verwendet, um mehr Teilnehmer zum Bereitstellen/Nutzen von Diensten zu motivieren und Token zu verwenden, um diesen Netzwerkeffekt zu nutzen und eine gemeinsame Nutzung der Vorteile für die Gemeinschaft zu erreichen.

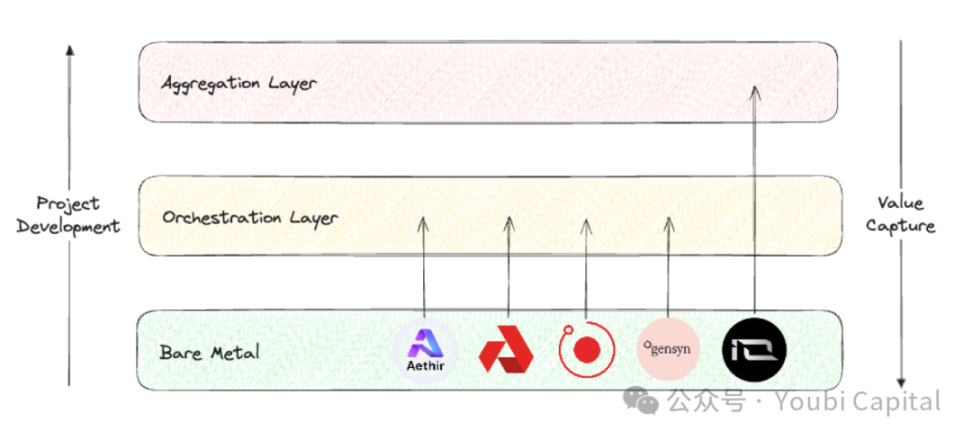

Wenn wir uns den gesamten Bereich der dezentralen Rechenleistung aus der Vogelperspektive ansehen, bietet der Forschungsbericht von Blockworks Research einen guten Analyserahmen. Wir können die Projektpositionen dieses Bereichs in drei verschiedene Ebenen unterteilen.

-

Blanke Metallschicht : Die Basisschicht des dezentralen Computer-Stacks. Ihre Hauptaufgabe besteht darin, Rohrechenressourcen zu sammeln und sie für API-Aufrufe verfügbar zu machen.

-

Orchestrierungsebene : Die mittlere Schicht des dezentralen Computer-Stacks. Ihre Hauptaufgaben sind Koordination und Abstraktion. Sie ist für die Planung, Erweiterung, den Betrieb, den Lastausgleich und die Fehlertoleranz der Rechenleistung verantwortlich. Ihre Hauptfunktion besteht darin, die Komplexität des zugrunde liegenden Hardwaremanagements zu abstrahieren und Endbenutzern eine erweiterte Benutzeroberfläche bereitzustellen, um bestimmte Kundengruppen zu bedienen.

-

Aggregationsschicht : Es bildet die oberste Schicht des dezentralen Computerstapels. Seine Hauptaufgabe ist die Integration. Es ist dafür verantwortlich, eine einheitliche Schnittstelle bereitzustellen, sodass Benutzer mehrere Computeraufgaben an einem Ort implementieren können, z. B. KI-Training, Rendering, zkML usw. Es entspricht der Orchestrierungs- und Verteilungsschicht mehrerer dezentraler Computerdienste.

Bildquelle: Youbi Capital

Basierend auf den beiden oben genannten Analyserahmen werden wir einen horizontalen Vergleich der fünf ausgewählten Projekte vornehmen und sie auf vier Ebenen bewerten: Kerngeschäft, Marktpositionierung, Hardwareausstattung und finanzielle Leistung .

2.1 Kerngeschäft

Aus der zugrunde liegenden Logik geht hervor, dass das dezentrale Computernetzwerk stark homogenisiert ist, d. h. Token werden verwendet, um Inhaber ungenutzter Rechenleistung dazu zu motivieren, Rechenleistungsdienste bereitzustellen. Basierend auf dieser zugrunde liegenden Logik können wir die Unterschiede im Kerngeschäft des Projekts aus drei Aspekten verstehen:

-

Quellen ungenutzter Rechenleistung:

-

Es gibt zwei Hauptquellen für ungenutzte Rechenleistung auf dem Markt: 1) ungenutzte Rechenleistung in den Händen von Rechenzentren, Minern und anderen Unternehmen; 2) ungenutzte Rechenleistung in den Händen von Privatanlegern. Bei der Rechenleistung von Rechenzentren handelt es sich in der Regel um professionelle Hardware, während Privatanleger in der Regel Chips für Verbraucher kaufen.

-

Die Rechenleistung von Aethir, Akash Network und Gensyn wird hauptsächlich von Unternehmen bezogen. Die Vorteile der Beauftragung von Rechenleistung von Unternehmen liegen darin, dass 1) Unternehmen und Rechenzentren in der Regel über qualitativ hochwertigere Hardware und professionelle Wartungsteams verfügen und die Leistung und Zuverlässigkeit der Rechenleistungsressourcen höher sind. 2) Die Rechenleistungsressourcen von Unternehmen und Rechenzentren sind häufig homogener und durch die zentrale Verwaltung und Überwachung werden Ressourcenplanung und -wartung effizienter. Allerdings stellt diese Methode dementsprechend höhere Anforderungen an den Projektbeteiligten und dieser muss über kommerzielle Verbindungen zu dem Unternehmen verfügen, das die Rechenleistung kontrolliert. Gleichzeitig werden Skalierbarkeit und Dezentralisierung in gewissem Maße beeinträchtigt.

-

Render Network und io.net ermutigen vor allem Kleinanleger, ihre ungenutzte Rechenleistung bereitzustellen. Die Vorteile der Nutzung von Rechenleistung von Privatanlegern sind: 1) Die expliziten Kosten für ungenutzte Rechenleistung von Privatanlegern sind gering, sodass wirtschaftlicher Rechenleistungsressourcen bereitgestellt werden können; 2) Das Netzwerk ist skalierbarer und dezentraler, was die Elastizität und Robustheit des Systems verbessert. Der Nachteil besteht darin, dass die Ressourcen des Einzelhandels weit verteilt und nicht einheitlich sind, was die Verwaltung und Planung kompliziert und den Betrieb und die Wartung erschwert. Es ist auch schwieriger, einen anfänglichen Netzwerkeffekt zu erzielen, wenn man sich auf die Rechenleistung des Einzelhandels verlässt (schwieriger zu starten). Schließlich können Geräte des Einzelhandels mehr Sicherheitsrisiken aufweisen, was das Risiko von Datenlecks und Rechenleistungsmissbrauch mit sich bringt.

-

Rechenleistungsverbraucher

-

Aus Sicht der Verbraucher von Rechenleistung sind die Zielkunden von Aethir, io.net und Gensyn hauptsächlich Unternehmen. Für B-Side-Kunden erfordern KI und Echtzeit-Rendering von Spielen Hochleistungs-Rechenleistung. Diese Art von Arbeitslast hat extrem hohe Anforderungen an Rechenleistungsressourcen und erfordert normalerweise High-End-GPUs oder professionelle Hardware. Darüber hinaus haben B-Side-Kunden hohe Anforderungen an die Stabilität und Zuverlässigkeit der Rechenleistungsressourcen, sodass hochwertige Service-Level-Agreements bereitgestellt werden müssen, um den normalen Betrieb des Projekts sicherzustellen und rechtzeitigen technischen Support bereitzustellen. Gleichzeitig sind die Migrationskosten für B-Side-Kunden sehr hoch. Wenn das dezentrale Netzwerk nicht über ein ausgereiftes SDK verfügt, das den Projektbeteiligten eine schnelle Bereitstellung ermöglicht (z. B. erfordert Akash Network, dass Benutzer selbst auf der Grundlage von Remote-Ports entwickeln), wird es für Kunden schwierig sein, zu migrieren. Ohne den extrem erheblichen Preisvorteil wäre die Migrationsbereitschaft der Kunden sehr gering.

-

Render Network und Akash Network bieten hauptsächlich Rechenleistungsdienste für Privatanleger an. Um Dienste für C-End-Benutzer bereitzustellen, müssen Projekte einfache und benutzerfreundliche Schnittstellen und Tools entwickeln, um den Verbrauchern ein gutes Verbrauchererlebnis zu bieten. Verbraucher sind auch sehr preisempfindlich, daher müssen Projekte wettbewerbsfähige Preise bieten.

-

Hardwaretyp

-

Zu den gängigen Computerhardwareressourcen gehören CPU, FPGA, GPU, ASIC und SoC. Diese Hardware weist erhebliche Unterschiede in Bezug auf Designziele, Leistungsmerkmalen und Anwendungsbereiche auf. Zusammenfassend lässt sich sagen, dass die CPU für allgemeine Computeraufgaben besser geeignet ist, die Vorteile von FPGAs in der hohen Parallelverarbeitung und Programmierbarkeit liegen, die GPU bei parallelen Computern gut abschneidet, ASIC bei bestimmten Aufgaben am effizientesten ist und SoC mehrere Funktionen in einer integriert und für hochintegrierte Anwendungen geeignet ist. Welche Hardware zu wählen ist, hängt von den Anforderungen der jeweiligen Anwendung, den Leistungsanforderungen und den Kosten ab. Die von uns besprochenen dezentralen Rechenleistungsprojekte dienen hauptsächlich zum Sammeln von GPU-Rechenleistung, die durch den Geschäftstyp des Projekts und die Eigenschaften der GPU bestimmt wird. Denn GPU bietet einzigartige Vorteile beim KI-Training, beim Parallelrechnen, beim Multimedia-Rendering und in anderen Aspekten.

-

Obwohl die meisten dieser Projekte eine GPU-Integration beinhalten, stellen unterschiedliche Anwendungen unterschiedliche Anforderungen an die Hardwarespezifikationen, sodass diese Hardware über heterogene Optimierungskerne und -parameter verfügt. Zu diesen Parametern gehören Parallelität/Seriell-Abhängigkeit, Speicher, Latenz und so weiter. Beispielsweise sind Rendering-Workloads eigentlich besser für GPUs der Verbraucherklasse geeignet als für leistungsstärkere GPUs für Rechenzentren, da Rendering hohe Anforderungen an Raytracing stellt und Chips der Verbraucherklasse wie 4090 über verbesserte RT-Kerne verfügen und speziell für Raytracing-Aufgaben optimiert sind. KI-Training und -Inferenz erfordern GPUs auf professionellem Niveau. Daher kann Render Network GPUs der Verbraucherklasse wie RTX 3090 und 4090 von Privatanlegern sammeln, während IO.NET mehr GPUs auf professionellem Niveau wie H 100 und A 100 benötigt, um die Anforderungen von KI-Startups zu erfüllen.

2.2 Marktpositionierung

In Bezug auf die Projektpositionierung müssen in der Bare-Metal-Schicht, der Orchestrierungsschicht und der Aggregationsschicht unterschiedliche Kernprobleme gelöst werden und es bestehen unterschiedliche Optimierungsschwerpunkte und Werterfassungsfunktionen.

-

Die Bare-Metal-Schicht konzentriert sich auf die Sammlung und Nutzung physischer Ressourcen, während die Orchestrierungsschicht sich auf die Planung und Optimierung der Rechenleistung konzentriert und das Design der physischen Hardware entsprechend den Anforderungen der Kundengruppen optimiert. Die Aggregationsschicht dient allgemeinen Zwecken und konzentriert sich auf die Integration und Abstraktion verschiedener Ressourcen. Aus Sicht der Wertschöpfungskette sollte jedes Projekt auf der Bare-Metal-Schicht beginnen und danach streben, nach oben zu klettern.

-

Aus Sicht der Werterfassung erhöht sich die Fähigkeit zur Werterfassung Schicht für Schicht, von der Bare-Metal-Schicht über die Orchestrierungsschicht bis hin zur Aggregationsschicht. Die Aggregationsschicht kann den größten Wert erfassen, da die Aggregationsplattform den größten Netzwerkeffekt erzielen und die meisten Benutzer direkt erreichen kann, was dem Verkehrseingang des dezentralen Netzwerks entspricht und somit die höchste Werterfassungsposition im gesamten Stapel zur Verwaltung von Computerressourcen einnimmt.

-

Dementsprechend ist der Aufbau einer Aggregationsplattform am schwierigsten. Das Projekt muss viele Probleme umfassend lösen, darunter technische Komplexität, heterogenes Ressourcenmanagement, Systemzuverlässigkeit und Skalierbarkeit, Realisierung von Netzwerkeffekten, Sicherheit und Datenschutz sowie komplexes Betriebs- und Wartungsmanagement. Diese Herausforderungen sind für den Kaltstart des Projekts nicht förderlich und hängen von der Entwicklung und dem Zeitplan des Tracks ab. Es ist nicht realistisch, eine Aggregationsschicht aufzubauen, bevor die Orchestrierungsschicht ausgereift ist und einen bestimmten Marktanteil erreicht hat.

-

Momentan, Aethir, Render Network, Akash Network und Gensyn gehören alle zur Orchestrierungsschicht und sind darauf ausgelegt, Dienste für bestimmte Ziele und Kundengruppen bereitzustellen. Aethirs derzeitiges Hauptgeschäft ist Echtzeit-Rendering für Cloud-Spiele und bietet bestimmte Entwicklungs- und Bereitstellungsumgebungen und -tools für B-Side-Kunden; Render Networks Hauptgeschäft ist Video-Rendering, Akash Networks hat es sich zur Aufgabe gemacht, eine Handelsplattform ähnlich wie Taobao bereitzustellen, und Gensyn ist stark im Bereich KI-Training engagiert. io.net ist als Aggregationsschicht positioniert, aber die derzeit von io implementierten Funktionen sind noch weit von den vollständigen Funktionen der Aggregationsschicht entfernt. Obwohl die Hardware von Render Network und Filecoin gesammelt wurde, sind die Abstraktion und Integration der Hardwareressourcen noch nicht abgeschlossen.

2.3 Hardware-Ausstattung

-

Derzeit haben nicht alle Projekte detaillierte Netzwerkdaten veröffentlicht. Relativ gesehen ist die Benutzeroberfläche des io.net-Explorers am besten, wo Sie Anzahl, Typ, Preis, Verteilung, Netzwerknutzung, Knoteneinkommen und andere Parameter von GPU/CPU sehen können. Ende April wurde jedoch das Frontend von io.net angegriffen. Da io keine Authentifizierung an der PUT/POST-Schnittstelle durchführte, manipulierten Hacker die Frontend-Daten. Dies war auch ein Alarmsignal für die Privatsphäre anderer Projekte und die Zuverlässigkeit der Netzwerkdaten.

-

In Bezug auf Anzahl und Modell der GPUs sollte io.net als Aggregationsschicht die meiste Hardware gesammelt haben. Aethir folgt dicht dahinter, und die Hardwaresituation anderer Projekte ist nicht so transparent. Aus dem GPU-Modell können wir ersehen, dass io sowohl professionelle GPUs wie A100 als auch GPUs für Verbraucher wie 4090 mit einer großen Vielfalt hat, was mit der Positionierung der io.net-Aggregation übereinstimmt. io kann die am besten geeignete GPU entsprechend den spezifischen Aufgabenanforderungen auswählen. GPUs verschiedener Modelle und Marken erfordern jedoch möglicherweise unterschiedliche Treiber und Konfigurationen, und die Software muss auch aufwendig optimiert werden, was die Komplexität von Verwaltung und Wartung erhöht. Derzeit basiert die Zuweisung verschiedener Aufgaben in io hauptsächlich auf der Benutzerauswahl.

-

Aethir hat seine eigene Mining-Maschine herausgebracht. Im Mai wurde Aethir Edge, das mit Unterstützung von Qualcomm entwickelt wurde, offiziell vorgestellt. Es wird den einzelnen zentralisierten GPU-Cluster-Bereitstellungsmodus weit weg von den Benutzern aufheben und Rechenleistung an den Rand bringen. Aethir Edge wird die Cluster-Rechenleistung von H100 kombinieren, um KI-Szenarien zu bedienen. Es kann trainierte Modelle bereitstellen und Benutzern Inferenz-Computing-Dienste zu den besten Kosten bieten. Diese Lösung ist näher an den Benutzern, bietet schnellere Dienste und ist kostengünstiger.

-

Aus Sicht von Angebot und Nachfrage zeigen die Statistiken von Akash Network als Beispiel, dass die Gesamtzahl der CPUs etwa 16.000 und die der GPUs 378 beträgt. Entsprechend der Netzwerkmietnachfrage beträgt die Auslastung der CPUs und GPUs 11,11 TP9T bzw. 19,31 TP9T. Darunter hat nur die professionelle GPU H100 eine relativ hohe Mietrate, und andere Modelle sind meist ungenutzt. Die Situation anderer Netzwerke ist ungefähr die gleiche wie bei Akash. Die Gesamtnachfrage nach dem Netzwerk ist nicht hoch. Mit Ausnahme beliebter Chips wie A100 und H100 sind andere Rechenleistungen meist ungenutzt.

-

Aus der Perspektive des Preisvorteils ist der Kostenvorteil gegenüber anderen traditionellen Dienstanbietern mit Ausnahme der Giganten auf dem Cloud-Computing-Markt nicht ausgeprägt.

2.4 Finanzielle Leistung

-

Unabhängig davon, wie das Token-Modell konzipiert ist, muss eine gesunde Tokenomics die folgenden Grundbedingungen erfüllen: 1) Die Benutzernachfrage nach dem Netzwerk muss sich im Münzpreis widerspiegeln, was bedeutet, dass der Token einen Wert erfassen kann; 2) Alle Teilnehmer, ob Entwickler, Knoten oder Benutzer, müssen langfristige und faire Anreize erhalten; 3) Gewährleistung einer dezentralen Verwaltung, um übermäßige Bestände durch Insider zu vermeiden; 4) Angemessene Inflations- und Deflationsmechanismen und Token-Freigabezyklen, um große Schwankungen der Münzpreise zu vermeiden, die die Robustheit und Nachhaltigkeit des Netzwerks beeinträchtigen.

-

Wenn wir das Token-Modell im Allgemeinen in BME (Burn and Mint Equilibrium) und SFA (Stake for Access) unterteilen, sind die Quellen des deflationären Drucks auf die Token dieser beiden Modelle unterschiedlich: Das BME-Modell verbrennt Token, nachdem Benutzer Dienste gekauft haben, sodass der deflationäre Druck des Systems durch die Nachfrage bestimmt wird. SFA erfordert, dass Dienstanbieter/Knoten Token einsetzen, um die Qualifikation zur Bereitstellung von Diensten zu erhalten, sodass der deflationäre Druck durch das Angebot entsteht. Der Vorteil von BME besteht darin, dass es besser für nicht standardisierte Waren geeignet ist. Wenn die Nachfrage nach dem Netzwerk jedoch nicht ausreicht, kann es dem Druck einer anhaltenden Inflation ausgesetzt sein. Die Token-Modelle verschiedener Projekte unterscheiden sich in Details, aber im Allgemeinen Aethir bevorzugt SFA, während io.net, Render Network und Akash Network BME bevorzugen und Gensyn noch unbekannt ist.

-

Aus der Umsatzperspektive wird sich die Nachfrage nach dem Netzwerk direkt im Gesamtumsatz des Netzwerks niederschlagen (der Umsatz der Miner wird hier nicht diskutiert, da Miner neben den Belohnungen für das Erfüllen von Aufgaben auch Subventionen vom Projekt erhalten). Aus den öffentlichen Daten hat io.net den höchsten Wert. Obwohl der Umsatz von Aethir noch nicht bekannt gegeben wurde, haben sie laut öffentlichen Informationen angekündigt, dass sie mit vielen B-Side-Kunden Aufträge unterzeichnet haben.

-

Was die Münzpreise angeht, haben nur Render Network und Akash Network ICOs durchgeführt. Aethir und io.net haben kürzlich ebenfalls Münzen ausgegeben, und ihre Preisentwicklung muss beobachtet werden, daher werden wir sie hier nicht im Detail besprechen. Gensyns Plan ist noch unklar. Von den beiden Projekten, die Münzen ausgegeben haben, und den Projekten, die Münzen im selben Track ausgegeben haben, aber nicht in den Umfang dieses Artikels einbezogen werden, Im Allgemeinen weist das dezentrale Rechenleistungsnetzwerk ein sehr beeindruckendes Preis-Leistungs-Verhältnis auf, das bis zu einem gewissen Grad das enorme Marktpotenzial und die hohen Erwartungen der Community widerspiegelt.

2.5 Zusammenfassung

-

Der Bereich dezentraler Computernetzwerke hat sich insgesamt rasant entwickelt, und viele Projekte können sich bereits auf Produkte verlassen, um Kunden zu bedienen und gewisse Einnahmen zu erzielen. Der Bereich hat sich von der reinen Erzählung entfernt und ist in eine Entwicklungsphase eingetreten, in der er vorläufige Dienste bereitstellen kann.

-

Schwache Nachfrage ist ein häufiges Problem bei dezentralen Computernetzwerken, und die langfristige Kundennachfrage wurde nicht gut überprüft und untersucht. Die Nachfrageseite hat den Preis der Münzen jedoch nicht allzu stark beeinflusst, und mehrere Projekte, die bereits Münzen ausgegeben haben, haben gute Ergebnisse erzielt.

-

KI ist das Hauptthema des dezentralen Computernetzwerks, aber nicht das einzige Geschäft. Neben der Verwendung für KI-Training und Inferenz kann die Rechenleistung auch für das Echtzeit-Rendering von Cloud-Spielen, Cloud-Mobiltelefondiensten und mehr verwendet werden.

-

Die Hardware-Heterogenität des Rechenleistungsnetzwerks ist relativ hoch und die Qualität und der Umfang des Rechenleistungsnetzwerks müssen weiter verbessert werden.

-

Für C-End-Benutzer ist der Kostenvorteil nicht sehr offensichtlich. Für B-End-Benutzer müssen sie neben den Kosteneinsparungen auch die Stabilität, Zuverlässigkeit, den technischen Support, die Compliance und die rechtliche Unterstützung des Dienstes usw. berücksichtigen, und Web3-Projekte schneiden in diesen Aspekten im Allgemeinen nicht gut ab.

3 Abschließende Gedanken

Das explosive Wachstum der KI hat einen enormen Bedarf an Rechenleistung geschaffen. Seit 2012 ist die Rechenleistung, die für KI-Trainingsaufgaben verwendet wird, exponentiell gewachsen und verdoppelt sich derzeit alle 3,5 Monate (im Vergleich zu Moores Gesetz, das eine Verdoppelung alle 18 Monate vorsieht). Seit 2012 ist der Bedarf an Rechenleistung mehr als 300.000-mal gestiegen und übertrifft damit das 12-fache Wachstum von Moores Gesetz bei weitem. Prognosen zufolge wird der GPU-Markt in den nächsten fünf Jahren voraussichtlich mit einer durchschnittlichen jährlichen Wachstumsrate von 321 TP9T auf über 1 TP10T200 Milliarden wachsen. AMDs Schätzung ist sogar noch höher und das Unternehmen erwartet, dass der GPU-Chipmarkt bis 2027 1 TP10T400 Milliarden erreichen wird.

Bildquelle: https://www.stateof.ai/

Denn das explosive Wachstum von künstlicher Intelligenz und anderen rechenintensiven Workloads (wie AR/VR-Rendering) hat strukturelle Ineffizienzen im traditionellen Cloud-Computing und in führenden Computermärkten offengelegt. Theoretisch können dezentrale Computernetzwerke flexiblere, kostengünstigere und effizientere Lösungen bieten, indem sie verteilte, ungenutzte Computerressourcen nutzen und so die enorme Nachfrage des Marktes nach Computerressourcen decken. Daher hat die Kombination von Krypto und KI ein enormes Marktpotenzial, sieht sich aber auch mit starker Konkurrenz durch traditionelle Unternehmen, hohen Eintrittsbarrieren und einem komplexen Marktumfeld konfrontiert. Generell sind dezentrale Computernetzwerke bei Betrachtung aller Krypto-Tracks eine der vielversprechendsten Vertikalen im Krypto-Bereich, die echte Bedürfnisse decken können.

Bildquelle : https://vitalik.eth.limo/general/2024/01/30/cryptoai.html

Die Zukunft ist rosig, aber der Weg dorthin ist steinig. Um die oben genannte Vision zu verwirklichen, müssen wir noch viele Probleme und Herausforderungen lösen. Zusammengefasst: Wenn wir in diesem Stadium nur traditionelle Cloud-Dienste anbieten, ist die Gewinnspanne der Projekte sehr gering. Auf der Nachfrageseite bauen große Unternehmen im Allgemeinen ihre eigene Rechenleistung auf, und reine C-End-Entwickler entscheiden sich meist für Cloud-Dienste. Ob kleine und mittlere Unternehmen, die wirklich dezentralisierte Rechenleistungsnetzwerkressourcen nutzen, eine stabile Nachfrage haben werden, muss noch weiter erforscht und überprüft werden. Auf der anderen Seite ist KI ein riesiger Markt mit sehr hohen Obergrenzen und Vorstellungsraum. Für einen breiteren Markt müssen Anbieter von dezentralisierten Rechenleistungsdiensten in Zukunft auch auf Modell-/KI-Dienste umsteigen, mehr Krypto- + KI-Nutzungsszenarien erkunden und den Wert erweitern, den das Projekt schaffen kann. Aber derzeit gibt es noch viele Probleme und Herausforderungen, um den Bereich KI weiter zu entwickeln:

-

Der Preisvorteil ist nicht überragend : Aus dem vorherigen Datenvergleich ist ersichtlich, dass sich der Kostenvorteil des dezentralen Computernetzwerks nicht widerspiegelt. Der mögliche Grund dafür ist, dass für professionelle Chips wie H100 und A100, die stark nachgefragt sind, der Marktmechanismus bestimmt, dass der Preis für diesen Teil der Hardware nicht billig sein wird. Darüber hinaus kann das dezentrale Netzwerk zwar ungenutzte Computerressourcen sammeln, aber der Mangel an Skaleneffekten durch Dezentralisierung, hohe Netzwerk- und Bandbreitenkosten sowie extrem komplexe Verwaltung und Betrieb und Wartung werden die Computerkosten weiter erhöhen.

-

Die Besonderheit des KI-Trainings : Im aktuellen Stadium des dezentralen KI-Trainings gibt es enorme technische Engpässe. Dieser Engpass lässt sich intuitiv im GPU-Workflow widerspiegeln. Beim Training großer Sprachmodelle empfängt die GPU zuerst die vorverarbeiteten Datenstapel und führt Vorwärts- und Rückwärtsausbreitungsberechnungen durch, um Gradienten zu erzeugen. Anschließend aggregiert jede GPU die Gradienten und aktualisiert die Modellparameter, um sicherzustellen, dass alle GPUs synchronisiert sind. Dieser Vorgang wird wiederholt, bis alle Trainingsstapel abgeschlossen sind oder die vorgegebene Anzahl von Runden erreicht ist. Dieser Vorgang erfordert eine große Menge an Datenübertragung und -synchronisierung. Welche Parallel- und Synchronisationsstrategien verwendet werden sollen, wie Netzwerkbandbreite und Latenz optimiert und Kommunikationskosten gesenkt werden können usw., ist noch nicht gut beantwortet. In diesem Stadium ist es nicht sehr realistisch, ein dezentrales Rechenleistungsnetzwerk zum Trainieren von KI zu verwenden.

-

Datensicherheit und Datenschutz : Während des Trainings großer Sprachmodelle können alle Aspekte der Datenverarbeitung und -übertragung, wie Datenverteilung, Modelltraining, Parameter- und Gradientenaggregation, die Datensicherheit und den Datenschutz beeinträchtigen. Darüber hinaus ist der Datenschutz wichtiger als der Modelldatenschutz. Wenn das Problem des Datenschutzes nicht gelöst werden kann, ist eine echte Skalierung auf der Nachfrageseite nicht möglich.

Aus realistischer Sicht muss ein dezentrales Computernetzwerk sowohl die aktuelle Nachfrage als auch den zukünftigen Marktraum berücksichtigen. Finden Sie die richtige Produktpositionierung und die richtigen Zielkundengruppen, z. B. indem Sie sich zuerst auf Nicht-KI- oder Web3-native Projekte konzentrieren, mit relativ geringen Anforderungen beginnen und eine frühe Benutzerbasis aufbauen. Erkunden Sie gleichzeitig weiterhin verschiedene Szenarien, in denen KI und Krypto kombiniert werden, erkunden Sie die Spitzentechnologie und erreichen Sie eine Transformation und Verbesserung der Dienste.

Verweise

https://vitalik.eth.limo/general/2024/01/30/cryptoai.html

https://foresightnews.pro/article/detail/34368

https://research.web3 caff.com/zh/archives/17351?ref=1554

Dieser Artikel stammt aus dem Internet: „Born at the Edge: Wie stärkt das dezentrale Rechenleistungsnetzwerk Krypto und KI?“

Originalquelle: Chain Teahouse 1. Projekteinführung io.net ist ein verteiltes GPU-System basierend auf Solana, Render, Ray und Filecoin, das darauf ausgelegt ist, verteilte GPU-Ressourcen zu nutzen, um Rechenherausforderungen in den Bereichen KI und maschinelles Lernen zu lösen. io.net löst das Problem unzureichender Rechenressourcen, indem es nicht ausgelastete Rechenressourcen wie unabhängige Datenverarbeitungszentren, Kryptowährungs-Miner und überschüssige GPUs aus Kryptoprojekten wie Filecoin und Render aggregiert und es Ingenieuren ermöglicht, große Mengen an Rechenleistung in einem leicht zugänglichen, anpassbaren und kostengünstigen System zu erhalten. Darüber hinaus führt io.net ein verteiltes physisches Infrastrukturnetzwerk (Depin) ein, das Ressourcen verschiedener Anbieter kombiniert, um Ingenieuren den Zugriff auf enorme Mengen an Rechenleistung auf anpassbare, kostengünstige und einfach zu implementierende Weise zu ermöglichen. io Cloud verfügt jetzt über mehr als 95.000 GPUs und mehr…