Marlin neu verstehen: Verifizierbares Computing L0 – Neue Infrastruktur in der zweiten Hälfte der KI

In der Kryptowelt gibt es nie einen Mangel an neuen Erzählungen, aber nur eine Handvoll davon können als sowohl sexy als auch pragmatisch beschrieben werden.

Seit dem Aufkommen dieser Runde von KI-Supererzählungen ist beispielsweise Cloud Computing zwar zum Kernproduktivwert der zukünftigen digitalen Wirtschaftsära geworden, doch die traditionellen Web2-Giganten haben ein Monopol auf hochwertige Hochleistungs-GPUs und Rechenleistungsressourcen, während Projekte im mittleren und unteren Leistungssegment weder Verhandlungsmacht noch Autonomie haben und auch breitere, überprüfbare Computeranwendungsszenarien vor dem Dilemma stehen, nichts mehr zu essen zu haben.

Daher sind im Zuge des KI+Krypto-Trends Konzepte wie die vollständig homomorphe Verschlüsselung (FHE) in den letzten Jahren zunehmend populär geworden und werden allgemein als eine der besten Lösungen für verifizierbares Computing und die vertrauliche KI-Datenverarbeitung angesehen.

In diesem Artikel geht es um Marlin, einen erfahrenen Kryptografieentwickler, der sich auf verifizierbare Cloud-Computing-Infrastrukturen spezialisiert hat. Außerdem wird untersucht, wie das DeAI-Projekt, das mehrere Themenbereiche wie KI, MEV, Oracle, ZK und TEE berührt, in den aktuellen KI-Trend passt und ob es neue Variablen in den Bereich KI+Krypto einbringen kann.

Die zweite Hälfte der KI kommt nicht ohne „verifizierbares Cloud Computing“ aus?

Wie wir alle wissen, werden neben der schnellen Ausweitung des großen AIGC-Modells auch zahllose KI-Szenarien in den frühen Stadien eines Ausbruchs, etwa in der medizinischen Versorgung, im Bildungswesen und beim intelligenten Fahren, schnell umgesetzt, was allesamt enorme Rechenleistung erfordert.

Doch für diese segmentierten Szenarien sind die medizinischen und pädagogischen Informationen der Benutzer sowie Informationen zum intelligenten Fahren allesamt Schlüsseldaten im Zusammenhang mit der Wirtschaft und sogar der Lebenssicherheit: Informationsdaten in Dimensionen wie Gesundheitsfürsorge, Energiesysteme, Bandbreitennetze und vernetzte Fahrzeuge stehen nicht nur in direktem Zusammenhang mit der Sicherheit vertraulicher persönlicher Daten, sondern erfordern auch einen umfassenderen Datenaustausch und eine umfassendere Zusammenarbeit, um die Streckenentwicklung voranzutreiben.

Gleichzeitig wird der traditionelle Cloud-Service-Markt jedoch von Internetgiganten wie Amazon Web Services (AWS), Microsoft Azure und Google Cloud Platform (GCP) dominiert. Die drei Unternehmen machen zusammen mehr als 601 Milliarden Dollar des Cloud-Computing-Marktes aus, der eindeutig ein Verkäufermarkt ist.

Das offensichtlichste Problem dieser Marktstruktur besteht in der weitverbreiteten Abhängigkeit von zentralisierten Cloud-Servern. Dies bedeutet, dass das Vertrauen der Entwickler/Projektbeteiligten in die von ihnen genutzten Cloud-Dienste im Wesentlichen stark vom Ruf eines oder mehrerer Giganten abhängt. Das wäre gleichbedeutend damit, die Datenautonomie und -sicherheit an die Web2-Riesen abzutreten.

Aus diesem Grund kam es in den letzten Jahren bei Cloud-Dienstanbietern häufig zu Datenlecks, die Einzelpersonen und Institutionen schwere Verluste zufügten. Unabhängig davon, wie Entwickler/Projektbeteiligte die Dezentralisierung, das Kernproblem der Kryptowelt, sehen, ist es daher weitaus besser, sie aus der Perspektive des Mechanismusdesigns so zu gestalten, dass sie nicht böse sein können (Can’t Be Evil), als zu glauben, dass die Giganten nicht böse sein werden (Don’t Be Evil).

Wenn wir in diesem Zusammenhang die Richtung des KI-Cloud-Computings sorgfältig analysieren, werden wir feststellen, dass zwischen den zugrunde liegenden und ausgereiften Cloud-Computing-Servicelösungen von Web2 immer noch eine ökologische Lücke besteht. Mit anderen Worten: Die Transformation der vertraulichen Computertechnologie ist mit hohen Kosten verbunden. Daher gibt es in der Branche keine besonders gute Lösung für die schnelle und sichere Bereitstellung von Programmen, was es unmöglich macht, die von KI+Web3 geforderte Reihe von Anwendungsfunktionen zu erfüllen, was auch die Entwicklungsdynamik einschränkt.

Um es ganz klar zu sagen: Für die Entwicklung der zweiten Hälfte des KI-Cloud-Computing-Marktes ist dringend ein vollständiger Satz von Blockchain-Entwicklungstools für Web3 erforderlich, um eine umfassende Lösung bereitzustellen, die die Anforderungen an Dezentralisierung, Verifizierbarkeit, geringe Latenz und niedrige Kosten erfüllt. Aus dieser Perspektive ist die Notwendigkeit dezentraler und verifizierbarer Cloud-Computing-Dienste allmählich aufgetaucht, was die Lücke in dieser Segmentierungsrichtung füllt:

In diesem Zusammenhang ist die Notwendigkeit dezentraler, überprüfbarer Cloud-Computing-Dienste allmählich aufgetaucht. Als Lösung, die Verschlüsselungstechnologie zur Durchführung von Berechnungen verwendet, ermöglicht sie Die Richtigkeit der Berechnungsergebnisse kann überprüft werden, ohne dass die zugrunde liegenden Daten preisgegeben werden. Dadurch werden weder private Informationen preisgegeben, noch ist sichergestellt, dass keine Schlüsseldaten verloren gehen.

All diese Dinge stehen in hohem Maße im Einklang mit den Anwendungsszenarien von Web3, was wiederum bei Branchenanwendern viel Fantasie in Bezug auf vertrauliches Cloud-Computing geweckt hat. Daher haben Themen wie Zero-Knowledge-Proof (ZKP), Multi-Party-Computing (MPC) und die neuerdings beliebte vollständig homomorphe Verschlüsselung (FHE) besondere Aufmerksamkeit vom Markt erhalten.

Dies ist, was Marlin erreichen möchte: Jede DePIN-/Web2.5-/AI-Anwendung kann, solange eine Nachfrage nach Rechendiensten mit geringer Latenz und hoher Rechenleistung besteht, tatsächlich auf WeTEE bereitgestellt werden und erhält dieselbe allgemeine Cloud-Computing-Lösung wie bei herkömmlichen Cloud-Diensten.

Marlin neu verstehen: So werden Sie ein nachweisbarer L0 in der KI-Welt

Wenn man Marlins Vision im Bereich des verifizierbaren KI-Computings in einem Satz zusammenfassen kann, dann ist es: In einer Zeit, in der das Training großer KI-Modelle immer wichtiger wird, ist es das Ziel des Unternehmens, bedürftigen KI-Computing-Nachfragern in Form von Plug-Ins auf Infrastrukturebene direkt zu helfen, verifizierbare Cloud-Computing-Dienste jederzeit und überall in ihre vorhandenen Produkte zu integrieren:

Dies ist im Wesentlichen ein überprüfbares universelles L0 in der KI-Welt, das die Kernfunktionen kapselt und Projektbeteiligten auf Basis des TEE-Hochleistungsknoten-Erweiterungsnetzwerks und des überprüfbaren ZK-Kommunikationsnetzwerks mit einem Klick aufrufbare Dienste bereitstellt:

Marlin verwendet eine vertrauenswürdige Ausführungsumgebung (TEE) und einen auf Zero-Knowledge-Proof (ZKP) basierenden Coprozessor, um Daten und Code auf Hardwareebene von anderen Prozessen zu isolieren. Dadurch wird die Vertraulichkeit der Daten und die Integrität der darin laufenden Berechnungen sichergestellt, während gleichzeitig die Genauigkeit und Überprüfbarkeit der Berechnungsergebnisse sichergestellt und diese manipulationssicher gemacht werden.

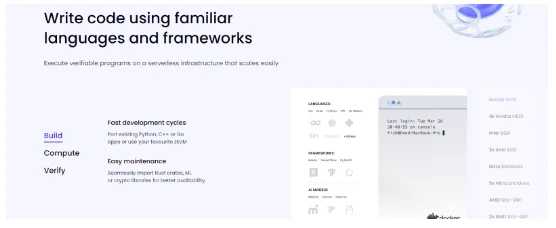

Gleichzeitig ist der ZK-Proof-Markt von Marlins im Gegensatz zu den meisten ZK-Coprozessoren, die für bestimmte Umgebungen (RISC-V, WASM oder MIPS) entwickelt wurden und nur Programme verarbeiten können, die in kompatiblen Sprachen geschrieben sind, schaltungsbasiert und daher sprachagnostisch, sodass Knoten die Schaltungen auswählen können, die sie unterstützen möchten – sie können vorhandene Python-, C++- oder Go-Anwendungen direkt portieren oder zkVM verwenden.

Gleichzeitig kann die Marlin-Netzwerkarchitektur als Ganzes in die drei Pferde Oyster, Kalypso und Relay-Netzwerk (Marlin Relay) unterteilt werden.

Oyster und Kalypso verwenden vertrauenswürdige Ausführungsumgebungen (TEEs) und Zero-Knowledge-Beweise (ZKPs), um die Richtigkeit bzw. Sicherheit der Berechnungen zu gewährleisten, während das Relay-Netzwerk dafür verantwortlich ist, sicherzustellen, dass nicht vertrauenswürdige Knoten Ressourcen zum Netzwerk beitragen können, ohne dessen Sicherheit durch integrierte Anreize zu beeinträchtigen:

-

Als Off-Chain-Dienst von TEE ist die Kernvision von Oysters um Benutzern die Bereitstellung ihres eigenen Backends oder die Implementierung von Smart-Contract-Erweiterungen im Marlin-Cloud-Computing-Netzwerk mit minimalen Änderungen zu ermöglichen. Daher ist die serverlose Funktion einer der größten Vorteile: Benutzer müssen keine Knoten einrichten und bestimmte zu verwendende Knoten auswählen, und die Ergebnisse können bequem an die Benutzer zurückgegeben werden.

-

Kalypso steht für Marlins flexible Integration von Zero-Knowledge-Proofs (ZKP). Hardwareoptimierung mit FPGA, GPU und ASIC kann die Generierung von ZK-Proofs erheblich beschleunigen und so Zeit und Kosten sparen. Das Marlin-Netzwerk verlässt sich auf Knoten mit GPUs und FPGAs, um die Generierung von ZK-Proofs auszulagern, wodurch Anfragen von Clients effizient verarbeitet und generierte Proofs zurückgegeben werden können.

-

Marlin Relay ist ein blockchain-agnostisches, erlaubnisfreies Relay-Netzwerk mit integrierten Anreizen, das gleichzeitig in mehrere Blockchains integriert werden kann. Diese Anreizstruktur stellt sicher, dass vertrauenslose Knoten Ressourcen zum Netzwerk beitragen können, ohne dessen Sicherheit zu beeinträchtigen.

Es ist erwähnenswert, dass jeder Knotenbetrieb und jede Knotenwartung im Marlins-Knotennetzwerk mit TEE ausgestattet ist und im Speichersystem eine sichere und isolierte Enklavenumgebung erstellt werden kann, um sicherzustellen, dass beim Berechnen und Speichern von Daten keine Informationen ausspioniert oder verloren gehen.

Und durch das ZK-Protokoll kann jeder Knoten der anderen Partei beweisen, dass eine Aussage wahr ist, ohne spezifische Daten über die Aussage preiszugeben. Dies schützt die Informationssicherheit der betroffenen Person und stellt gleichzeitig die Richtigkeit der Fakten sicher.

Im Allgemeinen ist Marlin als KI-orientiertes, verifizierbares Cloud-Computing L0 auf eine Vielzahl von Szenarien anwendbar. Basierend auf einem dezentral verteilten Knotennetzwerksystem kann es Bereitstellung von Netzwerkressourcendiensten wie Knotenrechenleistung und Speicher für Anwendungsszenarien wie Oracle Oracle, ZK Prover-System und künstliche Intelligenz der KI und wird zum Eckpfeiler des Datenschutzes vieler Verschlüsselungs- und KI-Anwendungen.

Marlin und der Vorstellungsraum der KI-Welt L0

Aus dieser Perspektive spielt Marlin in der zweiten Hälfte von AI+Web3 tatsächlich eine wichtige Infrastrukturrolle – der Kerngedanke besteht darin, wirklich verifizierbares Computing in die AI- und Web3-Welt zu bringen.

Mithilfe seines eigenen verifizierbaren L0-Cloud-Computing-Komponentendienstes kann Marlin beispielsweise noch einen Schritt weiter gehen und sich in einen Legostein verwandeln. Damit wird es zu einer zentralen Infrastrukturkomponente des verifizierbaren Computing + Dienstes von KIs und ermöglicht es DApp-Produkten in verschiedenen Bereichen, vollständig verifizierbare Computing-Eigenschaften zu erreichen.

Das direkteste Anwendungsszenario ist, dass Marlin eine sichere Modelltrainings- und Rechenumgebung für das KI-Modelltraining basierend auf dem TEE Trusted Execution Environment Coprozessor bereitstellen kann, und zwar zu einer Zeit, in der das Training großer KI-Modelle immer wichtiger wird. Das bedeutet, dass zusätzlich zu ChatGPT, Verschiedene große Modellprojekte können Marlin integrieren oder auf Marlin basierend aufbauen, um eine verifizierbare Computing-Middleware zu bilden, die einfach eingesteckt und verwendet werden kann, und sie so durch die Form des verifizierbaren Computing + ermöglichen.

Gleichzeitig kann, was noch wichtiger ist, eine dezentrale, transparente und überprüfbare Anreizumgebung aufgebaut werden, sodass das verteilte Knotennetzwerk in ein dezentrales Leasing-Dienstnetzwerk für Cloud-Computing-Leistung umgewandelt werden kann, d. h. eine breitere Palette von DePIN-Geschäftslogiken realisiert und die Kosten für Cloud-Computing-Dienste durch Token-Anreize gesenkt werden können:

Durch die Bündelung ungenutzter Rechenleistung und die Nutzung kostengünstigerer und flexiblerer Bereitstellungskonfigurationen wird die Ressourcennutzung erheblich verbessert, da Unternehmer so personalisiertere kleine und mittelgroße KI-Modelle trainieren können.

Dies ist nur die Spitze des Eisbergs der KI-Anwendungsszenarien, die Marlin als verifizierbare Computing-Middleware ermöglichen kann.

Zusammenfassung

Kurz gesagt, der wichtigste Vorstellungsraum, den Marlin in AI+Web3 bringen kann, ist dass es als Infrastruktur der L0-Schicht verschiedenen KI-Projektparteien ermöglicht, native verifizierbare Computerproduktdienste zu entwickeln (d. h. es wird als verifizierbare Computer-Middleware angesehen).

Tatsächlich ist dies als unverzichtbare Kernkomponente im Zeitalter von KI und Web3 gewissermaßen gleichbedeutend mit der Schlüsselinfrastruktur der Branche:

Von der zugrunde liegenden Abstimmung von Angebot und Nachfrage bei der Rechenleistung über die Bereitstellung von Oracle-Daten bis hin zu dezentralen Front-End-Diensten auf Basis verteilter Speicherung usw. kann grundsätzlich logisch ein geschlossener Kreislauf gebildet werden, der es Benutzern und Anwendungen ermöglicht, kostengünstig und flexibel auf überprüfbare Plug-in-Dienste für die Datenverarbeitung zuzugreifen, den Wert der Daten effektiv zu nutzen und auszuspielen und so die Grundlage für diversifizierte Anwendungsszenarien zu legen.

Klar ist, dass im zweiten Halbjahr der KI der Bereich des verifizierbaren Computings noch ein riesiges Wertpotenzial birgt, das darauf wartet, von uns erkundet zu werden. Insbesondere wenn das Konzept des verifizierbaren Computings + basierend auf der Kette von Web3 überlagert wird, könnte der Inhalt selbst noch großartiger sein.

Nicht nur KI, sondern fast alle denkbaren Anwendungen wie On-Chain-Unterhaltung, soziale Netzwerke, Spiele usw. können den Vorstellungsraum verifizierbarer Computer-/vertraulicher Datendienste weiter erweitern.

In diesem schrittweisen Aufbauprozess wird Marlin in Zukunft wahrscheinlich zur wichtigsten zugrunde liegenden Infrastruktur für allumfassende AI+Web3-Anwendungen. Dies könnte auch der größte Vorstellungsraum für verifizierbares Computing im AI+Web3-Zeitalter sein.

Dieser Artikel stammt aus dem Internet: Re-understanding Marlin: Verifiable Computing L0 Neue Infrastruktur in der zweiten Hälfte der KI

Verbunden: Avalanche (AVAX)-Analyse: Dieses Todeskreuz könnte die Korrektur verlängern

Kurz gesagt: Der Avalanche-Preis wird möglicherweise den anhaltenden Rückgang fortsetzen, da auf einem 12-Stunden-Chart ein Death Cross stattfindet. Preisindikatoren deuten auch darauf hin, dass bärische Signale an Stärke gewinnen. Auch die Anleger scheinen nicht sehr optimistisch zu sein, da ihre Stimmung überwiegend pessimistisch ist. Der Avalanche-Preis (AVAX) gehört zu den wenigen Altcoins, die Anzeichen eines weiteren Rückgangs im Zuge der Erholung zeigen. Was es für den Altcoin noch schwieriger macht, ist, dass selbst die AVAX-Investoren keine Rallye erwarten. Ist Avalanche zur Korrektur verurteilt? Zum Zeitpunkt des Schreibens wird der Avalanche-Preis nach Korrekturen und einer geringfügigen Erholung in den letzten Tagen unter $40 gehandelt. Während auf dem Markt Hoffnungen auf einen weiteren Preisanstieg aufkommen, ist dies bei AVAX nicht der Fall. Dies liegt daran, dass der…