Die nächste Welle narrativer Deduktion im Bereich der Krypto-KI: katalytische Faktoren, Entwicklungspfade und damit verbundene Ziele

Einführung

Bisher ist diese Runde des Krypto-Bullenmarktzyklus in Bezug auf Geschäftsinnovationen die langweiligste. Es fehlen phänomenale Hottracks wie DeFi, NFT und Gamefi im vorherigen Bullenmarkt, was zu einem Mangel an Branchen-Hotspots im Gesamtmarkt führt und das Wachstum von Benutzern, Brancheninvestitionen und Entwicklern relativ schwach ist.

Dies spiegelt sich auch in den aktuellen Vermögenspreisen wider. Während des gesamten Zyklus verlieren die Wechselkurse der meisten Alt-Coins gegenüber BTC weiterhin an Wert, einschließlich ETH. Schließlich wird die Bewertung von Smart-Contract-Plattformen durch den Erfolg der Anwendungen bestimmt. Wenn die Entwicklung und Innovation von Anwendungen mangelhaft sind, ist es auch schwierig, die Bewertung öffentlicher Ketten zu steigern.

Als relativ neue Krypto-Geschäftskategorie in dieser Runde hat KI von der explosiven Entwicklungsgeschwindigkeit und den ständigen Brennpunkten in der externen Geschäftswelt profitiert und wird KI-Track-Projekten in der Kryptowelt wahrscheinlich weiterhin eine deutliche Steigerung der Aufmerksamkeit bescheren.

In der IO.NET-Bericht In der im April vom Autor veröffentlichten Studie wurde die Notwendigkeit der Kombination von KI und Krypto geklärt. Das heißt, die Vorteile kryptoökonomischer Lösungen in Bezug auf Sicherheit, Mobilisierung und Zuweisung von Ressourcen und Vertrauenslosigkeit könnten eine der Lösungen für die drei Herausforderungen der KI-Zufälligkeit, Ressourcenintensität und Schwierigkeit bei der Unterscheidung zwischen Mensch und Maschine sein.

Im KI-Track der Kryptoökonomie versucht der Autor in einem weiteren Artikel, einige wichtige Themen zu diskutieren und abzuleiten, darunter:

-

Welche anderen Erzählungen tauchen im Bereich der Krypto-KI auf, die in Zukunft explodieren könnten?

-

Die katalytischen Pfade und die Logik dieser Erzählungen

-

Narrative Projektziele

-

Risiko und Unsicherheit bei der narrativen Deduktion

Dieser Artikel stellt die vorläufigen Überlegungen des Autors zum Zeitpunkt der Veröffentlichung dar. Er kann sich in Zukunft ändern und die Ansichten sind höchst subjektiv. Es können auch Fehler in Fakten, Daten und Argumentationslogik enthalten sein. Bitte verwenden Sie ihn nicht als Anlagereferenz. Kritik und Diskussion von Kollegen sind willkommen.

Nachfolgend der Haupttext.

Die nächste Welle von Erzählungen im Bereich Krypto-KI

Bevor wir die nächste Welle von Narrativen im Bereich der Krypto-KI formell überprüfen, schauen wir uns zunächst die wichtigsten Narrative der aktuellen Krypto-KI an. Aus der Perspektive der Marktkapitalisierung sind diejenigen mit einer Marktkapitalisierung von mehr als 1 Milliarde US-Dollar:

-

Rechenleistung: Render (RNDR, Marktwert 3,85 Milliarden), Akash (Marktwert 1,2 Milliarden), IO.NET (Bewertung der letzten Primärfinanzierungsrunde von 1 Milliarde)

-

Algorithmisches Netzwerk: Bittensor (TAO, Marktwert 2,97 Milliarden)

-

KI-Agent: Fetchai (FET, Marktwert vor der Fusion 2,1 Milliarden)

*Datenzeitpunkt: 24.05.2024, Währungseinheit ist US-Dollar.

Welcher KI-Bereich zusätzlich zu den oben genannten wird als nächstes einen Marktwert von über 1 Milliarde aufweisen?

Der Autor glaubt, dass darüber aus zwei Perspektiven spekuliert werden kann: der Erzählung der Angebotsseite der Branche und der Erzählung des GPT-Moments.

Die erste Perspektive der KI-Erzählung: Betrachtung der Energie- und Datenspurmöglichkeiten hinter KI aus Sicht der Industrieangebotsseite

Aus Sicht der Industrieversorgung sind die vier treibenden Kräfte hinter der Entwicklung der KI:

-

Algorithmen: Hochwertige Algorithmen können Trainings- und Inferenzaufgaben effizienter durchführen

-

Rechenleistung: Sowohl das Modelltraining als auch das Modellbegründungsmodell erfordern GPU-Hardware, um Rechenleistung bereitzustellen, was auch der Hauptengpass der Branche ist. Der Mangel an Chips in der Branche hat zu hohen Preisen für Chips der mittleren und oberen Preisklasse geführt.

-

Energie: Die von der KI benötigten Datenrechenzentren verbrauchen viel Energie. Zusätzlich zu der Leistung, die die GPU selbst benötigt, um Rechenaufgaben auszuführen, wird auch viel Energie benötigt, um die Wärmeableitung der GPU zu bewältigen. Das Kühlsystem eines großen Rechenzentrums macht etwa 401 TP9T des gesamten Energieverbrauchs aus.

-

Daten: Um die Leistung großer Modelle zu verbessern, ist eine Erweiterung der Trainingsparameter erforderlich, wofür eine große Menge qualitativ hochwertiger Daten erforderlich ist.

Was die treibenden Kräfte der oben genannten vier Branchen betrifft, so verfügen sowohl die Algorithmen- als auch die Rechenleistungssparte über Kryptoprojekte mit einer Marktkapitalisierung von mehr als 1 Milliarde US-Dollar, während es in den Sparten Energie und Daten bisher keine Projekte mit dem gleichen Marktwert gab.

Tatsächlich könnte es schon bald zu Versorgungsengpässen bei Energie und Daten kommen, die zu einer neuen Welle von Hotspots in der Branche führen und damit einen Boom bei Krypto-Projekten auslösen.

Lassen Sie uns zuerst über Energie sprechen.

Am 29. Februar 2024 sagte Musk auf der Bosch Connected World 2024-Konferenz: „Ich habe den Chipmangel schon vor über einem Jahr vorhergesagt. Der nächste Mangel wird Strom sein. Ich glaube, dass es nächstes Jahr nicht genug Strom geben wird, um alle Chips zu betreiben.“

Aus den spezifischen Daten veröffentlicht das Human-Centered Artificial Intelligence Institute der Stanford University unter der Leitung von Fei-Fei Li jedes Jahr den AI Index Report. In dem vom Team im Jahr 2022 veröffentlichten Bericht über die KI-Branche im Jahr 2021 schätzte das Forschungsteam, dass das Ausmaß des KI-Energieverbrauchs in diesem Jahr nur 0,91 TP9T des weltweiten Strombedarfs ausmachte und der Druck auf Energie und Umwelt begrenzt war. Im Jahr 2023 fasste die Internationale Energieagentur (IEA) das Jahr 2022 wie folgt zusammen: Globale Rechenzentren verbrauchten etwa 460 Terawattstunden (TWh) Strom, was 21 TP9T des weltweiten Strombedarfs entspricht, und prognostizierte, dass der globale Energieverbrauch von Rechenzentren bis 2026 mindestens 620 TWh und höchstens 1.050 TWh betragen wird.

Tatsächlich sind die Schätzungen der IEA noch konservativ, denn es stehen bereits zahlreiche KI-bezogene Projekte kurz vor der Markteinführung und der entsprechende Energiebedarf übersteigt bei weitem ihre Vorstellungen von vor 23 Jahren.

Beispielsweise planen Microsoft und OpenAI das Stargate-Projekt. Das Projekt soll 2028 beginnen und etwa 2030 abgeschlossen sein. Das Projekt sieht den Bau eines Supercomputers mit Millionen dedizierter KI-Chips vor, um OpenAI mit beispielloser Rechenleistung auszustatten und seine Forschung und Entwicklung im Bereich der künstlichen Intelligenz, insbesondere großer Sprachmodelle, zu unterstützen. Das Projekt wird voraussichtlich mehr als $100 Milliarden kosten, was 100-mal mehr ist als die derzeitigen Kosten für große Rechenzentren.

Allein der Energieverbrauch des Stargate-Projektes beträgt bis zu 50 Terawattstunden.

Deshalb sagte Sam Altman, Gründer von OpenAI, auf dem Davos Forum im Januar dieses Jahres: „Künstliche Intelligenz wird in Zukunft Durchbrüche im Energiebereich erfordern, da der Stromverbrauch künstlicher Intelligenz die Erwartungen der Menschen bei weitem übersteigen wird.“

Nach Rechenleistung und Energie dürfte der nächste Mangelbereich in der schnell wachsenden KI-Branche der Daten sein.

Mit anderen Worten: Der Mangel an qualitativ hochwertigen Daten, die für die KI erforderlich sind, ist Realität geworden.

Derzeit hat der Mensch das Gesetz des Wachstums der Fähigkeiten großer Sprachmodelle aus der Entwicklung von GPT im Wesentlichen durchschaut – das heißt, durch die Erweiterung der Modellparameter und Trainingsdaten können die Fähigkeiten der Modelle exponentiell verbessert werden – und es gibt in diesem Prozess kurzfristig keinen technischen Engpass.

Das Problem besteht jedoch darin, dass qualitativ hochwertige und öffentliche Daten in Zukunft möglicherweise immer knapper werden und dass KI-Produkte im Datenbereich möglicherweise mit dem gleichen Widerspruch zwischen Angebot und Nachfrage konfrontiert sind wie Chips und Energie.

Der erste ist die Zunahme von Streitigkeiten über das Eigentum an Daten.

Am 27. Dezember 2023 verklagte die New York Times OpenAI und Microsoft offiziell vor dem US-Bundesbezirksgericht. Sie warf ihnen vor, Millionen ihrer Artikel ohne Erlaubnis zum Trainieren des GPT-Modells verwendet zu haben, und forderte von ihnen gesetzliche und tatsächliche Schadensersatzzahlungen in Milliardenhöhe für das illegale Kopieren und Verwenden von Werken von einzigartigem Wert sowie die Vernichtung aller Modelle und Trainingsdaten, die urheberrechtlich geschützte Materialien der New York Times enthalten.

Ende März veröffentlichte die New York Times eine neue Erklärung, die sich nicht nur gegen OpenAI, sondern auch gegen Google und Meta richtete. In der Erklärung hieß es, OpenAI habe die Sprachteile einer großen Anzahl von YouTube-Videos mit einem Spracherkennungstool namens Whisper transkribiert und dann Text als Text generiert, um GPT-4 zu trainieren. Laut der New York Times ist es mittlerweile sehr üblich, dass große Unternehmen beim Training von KI-Modellen Kleindiebstähle anwenden, und Google tue dies ebenfalls. Sie wandeln auch YouTube-Videoinhalte in Text um, um ihre eigenen großen Modelle zu trainieren, was im Wesentlichen die Rechte der Ersteller von Videoinhalten verletzt.

New York Times vs. OpenAI ist der erste Urheberrechtsstreit im Bereich KI. Angesichts der Komplexität des Falls und seiner weitreichenden Auswirkungen auf die Zukunft von Inhalten und der KI-Branche ist es möglicherweise nicht möglich, bald eine Lösung zu finden. Ein möglicher Ausgang ist, dass sich die beiden Parteien außergerichtlich einigen und Microsoft und OpenAI, die über reichlich Geld verfügen, eine hohe Entschädigung zahlen. Weitere Streitigkeiten um das Urheberrecht von Daten in der Zukunft werden jedoch zwangsläufig die Gesamtkosten für qualitativ hochwertige Daten erhöhen.

Darüber hinaus hat Google, die größte Suchmaschine der Welt, angekündigt, dass das Unternehmen erwägt, für seine Suchfunktion Gebühren zu erheben. Allerdings richten sich diese Gebühren nicht an die breite Öffentlichkeit, sondern an KI-Unternehmen.

Quelle: Reuters

Die Suchmaschinenserver von Google speichern eine große Menge an Inhalten. Man kann sogar sagen, dass Google alle Inhalte speichert, die seit dem 21. Jahrhundert auf Internetseiten erschienen sind. Derzeit verarbeiten KI-gesteuerte Suchprodukte wie Perplexity in Übersee und Kimi und Mita in China diese gesuchten Daten mithilfe von KI und geben sie dann an die Benutzer aus. Die Gebühren für KI durch Suchmaschinen erhöhen zwangsläufig die Kosten für die Datenbeschaffung.

Tatsächlich haben die KI-Giganten neben öffentlichen Daten auch ein Auge auf nicht-öffentliche interne Daten geworfen.

Photobucket ist eine alteingesessene Foto- und Video-Hosting-Website, die Anfang der 2000er Jahre 70 Millionen Nutzer hatte und fast die Hälfte des US-amerikanischen Online-Fotomarktanteils innehatte. Mit dem Aufstieg der sozialen Medien ist die Zahl der Photobucket-Nutzer erheblich gesunken, und es sind nur noch 2 Millionen aktive Nutzer übrig (sie müssen eine hohe Gebühr von $399 pro Jahr zahlen). Gemäß der Vereinbarung und Datenschutzrichtlinie, die von den Nutzern bei der Registrierung unterzeichnet wurde, werden Konten, die länger als ein Jahr nicht verwendet wurden, wiederverwendet, und Photobucket unterstützt auch das Recht, die von den Nutzern hochgeladenen Bild- und Videodaten zu verwenden. Ted Leonard, CEO von Photobucket, gab bekannt, dass die 1,3 Milliarden Foto- und Videodaten, die es besitzt, für das Training generativer KI-Modelle äußerst wertvoll sind. Er verhandelt mit mehreren Technologieunternehmen über den Verkauf dieser Daten, wobei die Angebote von 5 Cent bis $1 pro Foto und mehr als $1 pro Video reichen. Er schätzt, dass die von Photobucket bereitgestellten Daten einen Wert von über $1 Milliarden haben.

EPOCH, ein Forschungsteam, das sich auf den Entwicklungstrend der künstlichen Intelligenz konzentriert, hat einen Bericht über die für maschinelles Lernen erforderlichen Daten veröffentlicht , Werden uns die Daten ausgehen? Eine Analyse der Grenzen der Skalierung von Datensätzen im maschinellen Lernen , basierend auf der Datennutzung und der Generierung neuer Daten im maschinellen Lernen im Jahr 2022, unter Berücksichtigung des Wachstums der Rechenressourcen. Der Bericht kommt zu dem Schluss, dass qualitativ hochwertige Textdaten zwischen Februar 2023 und 2026 erschöpft sein werden und Bilddaten zwischen 2030 und 2060 erschöpft sein werden. Wenn die Effizienz der Datennutzung nicht deutlich verbessert werden kann oder neue Datenquellen auftauchen, könnte sich der aktuelle Trend zu groß angelegten maschinellen Lernmodellen, die auf riesigen Datensätzen basieren, verlangsamen.

Gemessen an der aktuellen Situation, in der KI-Giganten Daten zu hohen Preisen kaufen, sind kostenlose Textdaten in hoher Qualität im Grunde erschöpft. Die Vorhersage von EPOCH vor zwei Jahren war relativ genau.

Gleichzeitig zeichnen sich auch Lösungen für den „KI-Datenmangel“ ab, nämlich: KI-Datenbereitstellungsdienste.

Defined.ai ist ein Unternehmen, das KI-Unternehmen maßgeschneiderte, echte und qualitativ hochwertige Daten bereitstellt.

Beispiele für Datentypen, die Defined.ai bereitstellen kann: https://www.defined.ai/datasets

Das Geschäftsmodell ist: KI-Unternehmen versorgen Defined.ai mit den Daten, die sie benötigen. Bei Bildern muss die Qualität beispielsweise eine bestimmte Auflösung übersteigen, Unschärfe und Überbelichtung müssen vermieden werden und der Inhalt muss authentisch sein. Was den Inhalt betrifft, können KI-Unternehmen bestimmte Themen entsprechend ihren eigenen Trainingsaufgaben anpassen, wie etwa Nachtaufnahmen, Pylonen, Parkplätze und Schilder bei Nacht, um die Erkennungsrate der KI bei Nachtszenen zu verbessern. Die Öffentlichkeit kann Aufgaben übernehmen, sie nach der Aufnahme hochladen und dann vom Unternehmen überprüfen lassen. Dann werden die Teile, die die Anforderungen erfüllen, anhand der Anzahl der Fotos vergeben. Der Preis beträgt etwa 1–2 US-Dollar für ein qualitativ hochwertiges Bild, 5–7 US-Dollar für einen Kurzfilm von mehr als 10 Sekunden, 100–300 US-Dollar für einen qualitativ hochwertigen Film von mehr als 10 Minuten und 1 US-Dollar für tausend Wörter Text. Diejenigen, die Aufgaben als Subunternehmer übernehmen, können etwa 20% der Gebühren erhalten. Die Datenbereitstellung kann nach der Datenkennzeichnung zu einem weiteren Crowdsourcing-Geschäft werden.

Globales Crowdsourcing von Aufgaben, wirtschaftliche Anreize, Preisgestaltung, Verbreitung und Datenschutz von Datenbeständen sowie die Teilnahme aller – das klingt nach einem Geschäft, das zum Web3-Paradigma passt.

Narrative Ziele der KI aus Sicht der industriellen Angebotsseite

Die durch den Chipmangel verursachte Besorgnis hat die Kryptoindustrie durchdrungen und die verteilte Rechenleistung zur bislang angesagtesten und wertvollsten KI-Sportkategorie gemacht.

Wenn also der Widerspruch zwischen Angebot und Nachfrage von Energie und Daten in der KI-Branche in den nächsten 1–2 Jahren ausbricht, welche narrativen Projekte gibt es derzeit in der Kryptobranche?

Werfen wir zunächst einen Blick auf die energiebezogenen Ziele.

Es gibt nur sehr wenige Energieprojekte, die an den wichtigsten CEXs notiert sind; lediglich Power Ledger (Token Powr) ist das einzige davon.

Power Ledger wurde 2017 gegründet. Es handelt sich um eine integrierte Energieplattform, die auf Blockchain-Technologie basiert. Ziel ist es, Energietransaktionen zu dezentralisieren, den direkten Stromhandel zwischen Einzelpersonen und Gemeinden zu fördern, die weit verbreitete Nutzung erneuerbarer Energien zu unterstützen und die Transparenz und Effizienz von Transaktionen durch intelligente Verträge sicherzustellen. Ursprünglich operierte Power Ledger auf einer Konsortialkette, die auf Ethereum basierte. In der zweiten Hälfte des Jahres 2023 aktualisierte Power Ledger sein Whitepaper und startete seine eigene integrierte öffentliche Kette, die aus dem technischen Rahmen von Solanas transformiert wurde, um die Verarbeitung hochfrequenter Mikrotransaktionen auf dem verteilten Energiemarkt zu erleichtern. Derzeit umfassen die Hauptgeschäftsbereiche von Power Ledger:

-

Energiehandel: Ermöglicht den direkten Kauf und Verkauf von Strom auf Peer-to-Peer-Basis, insbesondere von Strom aus erneuerbaren Quellen.

-

Handel mit Umweltprodukten: etwa der Handel mit Emissionsgutschriften und Zertifikaten für erneuerbare Energien sowie Finanzierungen auf Basis von Umweltprodukten.

-

Betrieb der öffentlichen Kette: Ziehen Sie Anwendungsentwickler an, um Anwendungen auf der Powerledger-Blockchain zu erstellen. Die Transaktionsgebühren der öffentlichen Kette werden in Powr-Tokens bezahlt.

Der aktuelle Marktwert des Power Ledger-Projekts beträgt $170 Millionen und der gesamte im Umlauf befindliche Marktwert beträgt $320 Millionen.

Im Vergleich zu energiebezogenen verschlüsselten Zielen ist die Anzahl der verschlüsselten Ziele in der Datenspur größer.

Der Autor listet nur die Data-Track-Projekte auf, die er derzeit im Auge hat und die auf mindestens einer der CEXs, Binance, OKX und Coinbase, gestartet sind, und ordnet sie von niedrig nach hoch gemäß FDV:

1. Streamr – DATEN

Das Wertversprechen von Streamr besteht darin, ein dezentrales Echtzeit-Datennetzwerk aufzubauen, das es den Benutzern ermöglicht, Daten frei zu handeln und zu teilen, während sie gleichzeitig die volle Kontrolle über ihre eigenen Daten behalten. Durch seine Daten MarktplatzStreamr möchte es Datenproduzenten ermöglichen, Datenströme ohne Zwischenhändler direkt an interessierte Verbraucher zu verkaufen und so die Kosten zu senken und die Effizienz zu steigern.

Quelle: https://streamr.network/hub/projects

In einem konkreten Kooperationsfall arbeitete Streamr mit DIMO, einem anderen Web3-Fahrzeug-Hardwareprojekt, zusammen, um über in Fahrzeugen installierte DIMO-Hardwaresensoren Temperatur, Luftdruck und andere Daten zu erfassen und so einen Wetterdatenstrom zur Übertragung an bedürftige Behörden zu erstellen.

Im Vergleich zu anderen Datenprojekten konzentriert sich Streamr mehr auf die Daten des Internets der Dinge und Hardwaresensoren. Neben den oben erwähnten DIMO-Fahrzeugdaten umfassen andere Projekte Echtzeit-Verkehrsdatenströme in Helsinki usw. Daher verdoppelte sich auch der Wert des Streamrs-Projekttokens DATA an einem einzigen Tag im Dezember letzten Jahres, als das Depin-Konzept am angesagtesten war.

Der aktuelle Marktwert des Streamr-Projekts beträgt $44 Millionen und der gesamte im Umlauf befindliche Marktwert beträgt $58 Millionen.

2. Kovalent – CQT

Im Gegensatz zu anderen Datenprojekten stellt Covalent Blockchain-Daten bereit. Das Covalent-Netzwerk liest Daten von Blockchain-Knoten über RPC und verarbeitet und organisiert die Daten dann, um eine effiziente Abfragedatenbank zu erstellen. Auf diese Weise können Covalent-Benutzer schnell die benötigten Informationen abrufen, ohne komplexe Abfragen direkt von Blockchain-Knoten aus durchführen zu müssen. Diese Art von Service wird auch als Blockchain-Datenindizierung bezeichnet.

Zu den Kunden von Covalents gehören hauptsächlich B-Seiten, darunter Dapp-Projekte wie verschiedene Defi und viele zentralisierte Krypto-Unternehmen wie Consensys (Muttergesellschaft von Metamask), CoinGecko (ein bekannter Marktplatz für Krypto-Assets), Rotki (Steuertool), Rainbow (Krypto-Wallet) usw. Darüber hinaus zählen Fidelity, ein Riese der traditionellen Finanzbranche, und Ernst Young, eine der vier großen Wirtschaftsprüfungsgesellschaften, ebenfalls zu den Kunden von Covalents. Laut den von Covalent veröffentlichten offiziellen Daten hat der Umsatz des Projekts aus Datendiensten den von The Graph, einem führenden Projekt auf demselben Gebiet, übertroffen.

Aufgrund der Integrität, Offenheit, Authentizität und Echtzeitnatur von On-Chain-Daten wird erwartet, dass die Web3-Branche zu einer hochwertigen Datenquelle für segmentierte KI-Szenarien und spezifische KI-Minimodelle wird. Als Datenanbieter hat Covalent begonnen, Daten für verschiedene KI-Szenarien bereitzustellen, und hat verifizierbare strukturierte Daten speziell für KI eingeführt.

Quelle: https://www.covalenthq.com/solutions/decentralized-ai/

Beispielsweise stellt es Daten für die intelligente On-Chain-Handelsplattform SmartWhales bereit und nutzt KI, um profitable Handelsmuster und Adressen zu identifizieren; Entendre Finance nutzt strukturierte Daten und KI-Verarbeitung von Covalents für Echtzeiteinblicke, Anomalieerkennung und prädiktive Analysen.

Derzeit liegen die Hauptszenarien der von Covalent bereitgestellten On-Chain-Datendienste noch hauptsächlich im Finanzbereich, aber mit der Verallgemeinerung von Web3-Produkten und -Datentypen werden die Nutzungsszenarien von On-Chain-Daten weiter erweitert.

Derzeit hat das Covalent-Projekt einen zirkulierenden Marktwert von $150 Millionen und einen vollständigen zirkulierenden Marktwert von $235 Millionen. Im Vergleich zu The Graph, einem Blockchain-Datenindexprojekt im selben Bereich, hat es einen relativ offensichtlichen Bewertungsvorteil.

3. Hivemapper – Honig

Unter allen Datenmaterialien ist der Stückpreis von Videodaten oft der höchste. Hivemapper kann KI-Unternehmen Daten einschließlich Video- und Karteninformationen bereitstellen. Hivemapper selbst ist ein dezentrales globales Kartenprojekt, das darauf abzielt, durch Blockchain-Technologie und Community-Beiträge ein detailliertes, dynamisches und zugängliches Kartensystem zu erstellen. Teilnehmer können Kartendaten über Dashcams erfassen und sie dem Open-Source-Datennetzwerk Hivemapper hinzufügen und erhalten basierend auf ihren Beiträgen Belohnungen im Projekt-Token HONEY. Um den Netzwerkeffekt zu verbessern und die Interaktionskosten zu senken, basiert Hivemapper auf Solana.

Hivemapper wurde 2015 mit der ursprünglichen Vision gegründet, mithilfe von Drohnen Karten zu erstellen. Später stellte sich jedoch heraus, dass dieses Modell schwer skalierbar war. Daher stieg das Unternehmen auf den Einsatz von Dashcams und Smartphones zur Erfassung geografischer Daten um und konnte so die Kosten für die globale Kartenerstellung senken.

Im Vergleich zu Street View- und Kartensoftware wie Google Map kann Hivemapper die Kartenabdeckung effizienter erweitern, die Aktualität realer Kartenszenen bewahren und die Videoqualität durch Anreiznetzwerke und Crowdsourcing-Modelle verbessern.

Bevor der Datenbedarf der KI explosionsartig anstieg, zählten zu den Hauptkunden von Hivemapper der Sektor des autonomen Fahrens in der Automobilindustrie, Navigationsdienstleister, Regierungen, Versicherungs- und Immobilienunternehmen usw. Heute kann Hivemapper KI und großen Modellen über APIs umfangreiche Straßen- und Umweltdaten bereitstellen. Mit der Eingabe kontinuierlich aktualisierter Bild- und Straßenmerkmal-Datenströme können KI- und ML-Modelle Daten besser in verbesserte Funktionen umwandeln und Aufgaben im Zusammenhang mit geografischer Ortung und visueller Beurteilung ausführen.

Datenquelle: https://hivemapper.com/blog/diversify-ai-computer-vision-models-with-global-road-imagery-map-data/

Derzeit beträgt der im Umlauf befindliche Marktwert des Hivemapper-Honey-Projekts $120 Millionen und der gesamte im Umlauf befindliche Marktwert beträgt $496 Millionen.

Neben den oben genannten drei Projekten gibt es im Datenbereich noch weitere Projekte, darunter The Graph – GRT (Marktwert von $3,2 Milliarden, FDV von $3,7 Milliarden), dessen Geschäft Covalent ähnelt und ebenfalls Blockchain-Datenindizierungsdienste anbietet, sowie Ocean Protocol – OCEAN (Marktwert von $670 Millionen, FDV von $1,45 Milliarden, dieses Projekt steht kurz vor der Fusion mit Fetch.ai und SingularityNET, und der Token wird in ASI umgewandelt), ein Open-Source-Protokoll, das den Austausch und die Monetarisierung von Daten und datenbezogenen Diensten erleichtern und Datenkonsumenten mit Datenanbietern verbinden soll, um Daten auszutauschen und gleichzeitig Vertrauen, Transparenz und Rückverfolgbarkeit zu gewährleisten.

Die zweite Perspektive der KI-Erzählung: Der GPT-Moment taucht wieder auf, die allgemeine künstliche Intelligenz kommt

Meiner Meinung nach ist das erste Jahr des KI-Tracks in der Kryptoindustrie das Jahr 2023, als GPT die Welt schockierte. Der Anstieg der Krypto-KI-Projekte ist eher eine Folge der explosiven Entwicklung der KI-Industrie.

Obwohl die Fähigkeiten von GPT 4, Turbo usw. nach GPT 3.5 kontinuierlich verbessert wurden, Sora erstaunliche Fähigkeiten zur Videoerstellung bewiesen hat und sich auch große Sprachmodelle außerhalb von OpenAI rasant entwickelt haben, lässt sich nicht leugnen, dass die kognitiven Auswirkungen des technologischen Fortschritts der KI auf die Öffentlichkeit nachlassen, die Menschen allmählich beginnen, KI-Tools zu verwenden und ein großflächiger Ersatz von Arbeitsplätzen noch nicht stattgefunden zu haben scheint.

Wird es also in Zukunft einen weiteren GPT-Moment im Bereich der KI geben, mit einem Sprung nach vorne in der KI, der die Öffentlichkeit schockiert und den Menschen klar macht, dass sich ihr Leben und ihre Arbeit dadurch verändern werden?

Dieser Moment könnte das Aufkommen der künstlichen allgemeinen Intelligenz (AGI) sein.

AGI bezeichnet Maschinen, die über umfassende kognitive Fähigkeiten verfügen, die denen des Menschen ähneln und eine Vielzahl komplexer Probleme lösen können, nicht nur bestimmte Aufgaben. AGI-Systeme haben die Fähigkeit, hochgradig abstrakt zu denken, verfügen über umfangreiches Hintergrundwissen, können in allen Bereichen über gesunden Menschenverstand urteilen, kausale Zusammenhänge verstehen und Lernprozesse fachübergreifend übertragen. Die Leistung künstlicher Intelligenz (AGI) unterscheidet sich in den einzelnen Bereichen nicht von der der besten Menschen und übertrifft hinsichtlich ihrer umfassenden Fähigkeiten die beste menschliche Gruppe bei weitem.

Ob es nun in Science-Fiction-Romanen, Spielen, Filmen und Fernsehsendungen dargestellt wird oder in den Erwartungen der Öffentlichkeit nach der schnellen Popularisierung von GPT, die Öffentlichkeit hat schon lange auf die Entstehung von AGI gewartet, die das Niveau der menschlichen Wahrnehmung übersteigt. Mit anderen Worten, GPT selbst ist der Vorläufer von AGI und die prophetische Version der allgemeinen künstlichen Intelligenz.

Der Grund für die enorme industrielle Energie und psychologische Wirkung von GPT liegt darin, dass die Geschwindigkeit seiner Umsetzung und Leistung die Erwartungen der Öffentlichkeit übertroffen hat: Die Leute hätten nicht erwartet, dass es tatsächlich ein künstliches Intelligenzsystem geben würde, das den Turing-Test bestehen kann, und das auch noch in so einer hohen Geschwindigkeit.

Tatsächlich könnte künstliche Intelligenz (AGI) den plötzlichen Moment des GPT-Ereignisses innerhalb von ein bis zwei Jahren wiederholen: Die Menschen haben sich einfach an die Unterstützung durch GPT gewöhnt und stellen fest, dass KI nicht mehr nur ein Assistent ist. Sie kann sogar selbständig äußerst kreative und anspruchsvolle Aufgaben erledigen, darunter auch jene schwierigen Probleme, an denen menschliche Spitzenwissenschaftler jahrzehntelang gefesselt waren.

Am 8. April dieses Jahres wurde Musk von Nicolai Tangen, dem Chief Investment Officer des norwegischen Staatsfonds, interviewt und sprach darüber, wann AGI erscheinen wird.

„Wenn man AGI als intelligenter als die intelligentesten Menschen definiert, halte ich es für sehr wahrscheinlich, dass dies bis 2025 der Fall sein wird“, sagte er.

Das heißt, seiner Schlussfolgerung zufolge wird es höchstens eineinhalb Jahre dauern, bis AGI ankommt. Natürlich fügte er eine Voraussetzung hinzu, nämlich, ob Elektrizität und Hardware mithalten können.

Die Vorteile der Einführung von AGI liegen auf der Hand.

Das bedeutet, dass die Produktivität der Menschheit erheblich gesteigert wird und eine große Zahl wissenschaftlicher Forschungsprobleme, die uns seit Jahrzehnten beschäftigen, gelöst werden. Wenn wir den intelligentesten Teil der Menschheit als die Ebene der Nobelpreisträger definieren, bedeutet das, dass wir, solange genügend Energie, Rechenleistung und Daten vorhanden sind, unzählige unermüdliche Nobelpreisträger haben können, die rund um die Uhr daran arbeiten, die schwierigsten wissenschaftlichen Probleme zu lösen.

Tatsächlich sind Nobelpreisträger nicht so selten wie einer unter hundert Millionen. Die meisten von ihnen sind in Bezug auf Fähigkeiten und Intelligenz auf dem Niveau von Professoren an Spitzenuniversitäten, aber aufgrund von Wahrscheinlichkeit und Glück haben sie die richtige Richtung gewählt, weiter daran gearbeitet und die Ergebnisse erzielt. Menschen auf dem gleichen Niveau wie er, seine ebenso hervorragenden Kollegen, haben möglicherweise auch im Paralleluniversum der wissenschaftlichen Forschung den Nobelpreis gewonnen. Aber leider gibt es immer noch nicht genug Menschen, die Professoren an Spitzenuniversitäten sind und an wissenschaftlichen Forschungsdurchbrüchen beteiligt sind, sodass die Geschwindigkeit, mit der alle richtigen Richtungen der wissenschaftlichen Forschung durchlaufen werden, immer noch sehr langsam ist.

Mit AGI können wir, wenn Energie und Rechenleistung vollständig bereitgestellt werden, unbegrenzt AGIs auf Nobelpreisträger-Niveau haben, um in jeder möglichen wissenschaftlichen Durchbruchsrichtung gründliche Forschung zu betreiben, und die Geschwindigkeit des technologischen Fortschritts wird Dutzende Male höher sein. Der technologische Fortschritt wird in 10 bis 20 Jahren zu einer Verhundertfachung von Ressourcen führen, die wir heute als ziemlich teuer und knapp betrachten, wie etwa Lebensmittelproduktion, neue Materialien, neue Medikamente, hochrangige Bildung usw. Die Kosten für deren Beschaffung werden ebenfalls exponentiell sinken, sodass wir mehr Menschen mit weniger Ressourcen ernähren können, und der Pro-Kopf-Wohlstand wird schnell steigen.

Globales BIP-Trenddiagramm, Datenquelle: Weltbank

Das mag ein wenig sensationell klingen, aber schauen wir uns zwei Beispiele an, die ich in früheren Forschungsberichte zu IO.NET :

-

2018 sagte Francis Arnold, Nobelpreisträger für Chemie, bei der Preisverleihung: „Heute können wir in praktischen Anwendungen jede DNA-Sequenz lesen, schreiben und bearbeiten, aber wir können sie noch nicht zusammensetzen.“ Nur fünf Jahre nach seiner Rede, im Jahr 2023, veröffentlichten Forscher der Stanford University und von Salesforce Research, einem KI-Startup aus dem Silicon Valley, einen Artikel in Nature Biotechnology. Sie erstellten 1 Million neue Proteine von Grund auf mithilfe eines großen, auf GPT 3 basierenden, fein abgestimmten Sprachmodells und fanden 2 Proteine mit völlig unterschiedlichen Strukturen, aber beide mit bakterizider Wirkung, die voraussichtlich neben Antibiotika zu einer bakteriellen antibakteriellen Lösung werden. Mit anderen Worten: Mithilfe von KI wurde der Engpass bei der Proteinerstellung durchbrochen.

-

Zuvor hatte der künstliche Intelligenz-Algorithmus AlphaFold innerhalb von 18 Monaten fast alle 214 Millionen Proteinstrukturen der Erde vorhergesagt. Diese Leistung übertrifft die Arbeit aller bisherigen Strukturbiologen um ein Hundertfaches.

Der Wandel ist bereits im Gange und die Einführung der AGI wird diesen Prozess noch weiter beschleunigen.

Andererseits sind auch die Herausforderungen, die die Einführung künstlicher Intelligenz (AGI) mit sich bringt, enorm.

AGI wird nicht nur eine große Zahl geistiger Arbeitskräfte ersetzen, sondern auch physische Dienstleistungsarbeiter, die derzeit als weniger von KI betroffen gelten, werden durch die Weiterentwicklung der Robotertechnologie und die durch die Forschung und Entwicklung neuer Materialien bedingten Senkungen der Produktionskosten betroffen sein. Der Anteil der durch Maschinen und Software ersetzten Arbeitsplätze wird rasch zunehmen.

Zu diesem Zeitpunkt werden zwei Probleme auftauchen, die einst sehr weit entfernt schienen:

-

Beschäftigungs- und Einkommensprobleme für eine große Zahl arbeitsloser Menschen

-

Wie kann man in einer Welt, in der KI allgegenwärtig ist, zwischen KI und Menschen unterscheiden?

WorldcoinWorldchain versucht, eine Lösung bereitzustellen, die darin besteht, das UBI-System (Universal Basic Income) zu nutzen, um der Öffentlichkeit ein Grundeinkommen bereitzustellen und irisbasierte Biometrie zu verwenden, um zwischen Menschen und KI zu unterscheiden.

Tatsächlich ist das BGE, das jedem Geld gibt, ohne echte Praxis kein Luftschloss. Länder wie Finnland und England haben ein allgemeines Grundeinkommen eingeführt, und politische Parteien in Kanada, Spanien, Indien und anderen Ländern schlagen aktiv vor, entsprechende Experimente zu fördern.

Der Vorteil der Verteilung von UBI auf der Grundlage des biometrischen Erkennungs- + Blockchain-Modells besteht darin, dass das System global ist und eine größere Bevölkerung abdeckt. Darüber hinaus können auf der Grundlage des durch Einkommensverteilung erweiterten Benutzernetzwerks andere Geschäftsmodelle aufgebaut werden, wie z. B. Finanzdienstleistungen (Defi), soziale Netzwerke, Aufgaben-Crowdsourcing usw., um Geschäftssynergien innerhalb des Netzwerks zu bilden.

Eines der entsprechenden Ziele für den Impact-Effekt, der durch das Aufkommen von AGI hervorgerufen wird, ist Worldcoin – WLD, dessen Umlaufmarktwert $1,03 Milliarden und dessen Gesamtumlaufmarktwert $47,2 Milliarden beträgt.

Risiko und Unsicherheit bei der narrativen Deduktion

Dieser Artikel unterscheidet sich von vielen zuvor von Mint Ventures veröffentlichten Projekt- und Track-Forschungsberichten. Die Schlussfolgerungen und Vorhersagen der Erzählung sind höchst subjektiv. Bitte behandeln Sie den Inhalt dieses Artikels als eine abweichende Diskussion und nicht als eine Vorhersage der Zukunft. Die oben genannten narrativen Schlussfolgerungen sind mit vielen Unsicherheiten behaftet, die zu falschen Vermutungen führen. Zu diesen Risiken oder Einflussfaktoren gehören unter anderem:

-

Energie: GPU-Upgrades führen zu einem rapiden Rückgang des Energieverbrauchs

Obwohl der Energiebedarf für KI stark gestiegen ist, sorgen Chiphersteller wie NVIDIA durch kontinuierliche Hardware-Upgrades für höhere Rechenleistung bei geringerem Stromverbrauch. Im März dieses Jahres brachte NVIDIA beispielsweise eine neue Generation der KI-Rechenkarte GB 200 auf den Markt, die zwei B 200-GPUs und eine Grace-CPU integriert. Ihre Trainingsleistung ist viermal so hoch wie die der vorherigen Generation der wichtigsten KI-GPU H 100 und ihre Denkleistung siebenmal so hoch wie die der H 100, aber der erforderliche Energieverbrauch beträgt nur 1/4 des H 100. Natürlich ist der Wunsch der Menschen nach Leistung aus der KI trotz alledem noch lange nicht vorbei. Mit dem Rückgang des Energieverbrauchs pro Einheit und der weiteren Ausweitung der KI-Anwendungsszenarien und -Nachfrage könnte der Gesamtenergieverbrauch tatsächlich steigen.

-

Daten: Q* plant, selbst generierte Daten zu erreichen

Es gab schon immer Gerüchte über ein Projekt Q* innerhalb von OpenAI, das in einer internen Nachricht von OpenAI an die Mitarbeiter erwähnt wurde. Laut Reuters, die sich auf OpenAI-Insider beruft, könnte dies ein Durchbruch für OpenAI bei seinem Streben nach Superintelligenz/allgemeiner künstlicher Intelligenz (AGI) sein. Q* kann mit seiner abstrakten Fähigkeit nicht nur mathematische Probleme lösen, die noch nie zuvor gesehen wurden, sondern auch selbst Daten zum Trainieren großer Modelle erstellen, ohne dass Daten aus der realen Welt benötigt werden. Wenn das Gerücht stimmt, wird der Engpass beim Training großer KI-Modelle, der durch unzureichende Daten hoher Qualität begrenzt ist, durchbrochen.

-

Das Aufkommen der AGI: Die verborgenen Sorgen von OpenAI

Ob AGI im Jahr 2025 kommen wird, wie Musk sagte, ist noch unbekannt, aber es ist nur eine Frage der Zeit. Als direkter Nutznießer der AGI-Advent-Erzählung könnte Worldcoins größte Sorge jedoch von OpenAI ausgehen, schließlich wird es als „OpenAI-Schattentoken“ anerkannt.

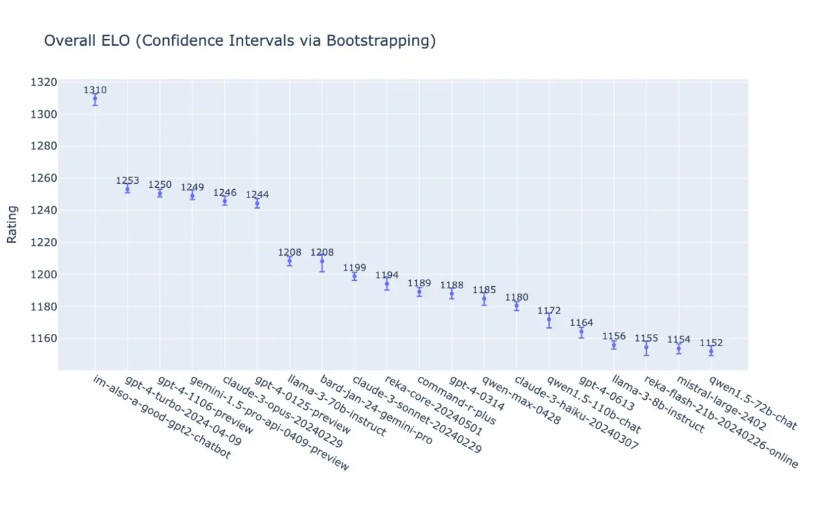

Am frühen Morgen des 14. Mai demonstrierte OpenAI auf seiner Frühjahrskonferenz zur Einführung neuer Produkte die Leistung des neuesten GPT-4 o und 19 weiterer Versionen großer Sprachmodelle in umfassenden Aufgabenbewertungen. Allein nach der Tabelle zu urteilen, erreichte GPT-4 o eine Punktzahl von 1310, was optisch viel höher zu sein scheint als die letzteren, aber in Bezug auf die Gesamtpunktzahl ist es nur 4,51 TP9T höher als der zweitplatzierte GPT 4 Turbo, 4,91 TP9T höher als der viertplatzierte Google Gemini 1.5 Pro und 5,11 TP9T höher als der fünftplatzierte Anthropic Claude 3 Opus.

Es ist etwas mehr als ein Jahr vergangen, seit GPT 3.5 die Welt mit seiner Erstveröffentlichung schockierte, und die Konkurrenten von OpenAI haben bereits sehr dicht aufgeholt (obwohl GPT 5 noch nicht veröffentlicht wurde und voraussichtlich noch in diesem Jahr erscheinen wird). Ob OpenAI seine führende Position in der Branche in Zukunft behaupten kann, scheint unklar zu werden. Wenn der führende Vorsprung und die Dominanz von OpenAI verwässert oder sogar übertroffen werden, wird auch der narrative Wert von Worldcoin als Schattentoken von OpenAI abnehmen.

Neben Worldcoins Iris-Authentifizierungslösung drängen immer mehr Wettbewerber auf diesen Markt. So hat beispielsweise das Handflächen-Scan-ID-Projekt Humanity Protocol gerade eine neue Finanzierungsrunde in Höhe von $30 Millionen bei einer Bewertung von $1 Milliarden angekündigt. LayerZero Labs kündigte außerdem an, dass es auf Humanity laufen und sich dessen Validator-Knotennetzwerk anschließen wird, wobei ZK-Beweise zur Authentifizierung von Anmeldeinformationen verwendet werden.

Abschluss

Abschließend sei bemerkt, dass sich der KI-Track, obwohl der Autor die nachfolgende Erzählung des KI-Tracks abgeleitet hat, von krypto-nativen Tracks wie DeFi unterscheidet. Er ist eher ein Produkt des Übergreifens des KI-Wahns auf den Währungskreis. Viele aktuelle Projekte waren in Bezug auf Geschäftsmodelle nicht erfolgreich, und viele Projekte ähneln eher KI-Memes (zum Beispiel ähnelt Rndr dem Meme von Nvidia und Worldcoin dem Meme von OpenAI). Leser sollten sie mit Vorsicht betrachten.

Dieser Artikel stammt aus dem Internet: Die nächste Welle der narrativen Deduktion im Bereich der Krypto-KI: katalytische Faktoren, Entwicklungspfade und damit verbundene Ziele

Original|Odaily Planet Daily Autor: Azuma Letztes Wochenende hat Blast offiziell die Verteilungsdetails der zweiten Phase von Gold Points (Blast Gold) bekannt gegeben und angekündigt, dass es diese Woche insgesamt 10 Millionen Gold Points an 70 ökologische Projekte verteilen wird. Als weiterer wichtiger Indikator zur Beitragsbewertung, der unabhängig vom normalen Punktesystem ist und immer mehr aufgebläht wird, gelten die Gold Points auch als die wertvollsten bei Blast, da Blast zuvor erklärt hat, dass 50% der Airdrop-Anteile an Gold Point-Inhaber zugeteilt werden. Im Vergleich zur ersten Phase der Zuteilungsmöglichkeiten hat sich die Gesamtzuteilung von Golden Points in dieser Phase (10 Millionen) nicht geändert, aber die Anzahl der ausgewählten Projekte wurde halbiert (140 in der ersten Phase), und Blast hat…